Toutes les start-ups s’en revendiquent, les acteurs du Digital ou du Marketing la mentionnant sont légion, comme signe de leur expertise et garantie de votre succès commun. L’Intelligence Artificielle est présentée comme l’alpha et l’omega de toute technologie Digitale. Mais est-ce vraiment pertinent pour vous ? Doit-on forcément utiliser l’IA pour générer de la valeur avec des données ? Voici quelques clés pour décrypter une bonne partie du bullshit !

Sommaire

- Qu'est-ce que l'Intelligence Artificielle ?

- Les conditions pour qu'une IA fonctionne bien

- Les pièges de l'IA dans le marketing

- Donc on jette l'intelligence artificielle à la poubelle ?

- Attention aux biais !

- 3 bonus pour aller plus loin

À l’image de mes précédents propos liminaires (voir ici et là), je veux juste être certain de ne pas être mal compris. Même si dans cet article j’essaye de déconstruire quelques croyances sur l’intelligence artificielle, je ne conteste en rien le boom de ce domaine ni le fait qu’elle (l’AI) puisse apporter un vrai gain dans certains cas concrets (et de plus en plus nombreux). Ne me faites donc pas dire ce que je n’ai pas dit : l’intelligence artificielle n’est pas bullshit du tout. Son évocation ou son utilisation par contre…

Qu’est-ce que l’Intelligence Artificielle ?

D’après Wikipedia, voici la définition (pas si claire) de l’Intelligence Artificielle :

L’intelligence artificielle (IA) est « l’ensemble de théories et de techniques mises en œuvre en vue de réaliser des machines capables de simuler l’intelligence »1)source : Larousse : http://www.larousse.fr/encyclopedie/divers/intelligence_artificielle/187257 . Elle correspond donc à un ensemble de concepts et de technologies plus qu’à une discipline autonome constituée. D’autres, remarquant la définition peu précise de l’IA, notamment la CNIL, la définissent comme « le grand mythe de notre temps ».

Vous remarquerez que dès la définition, est évoquée cette notion de mythe. Mais pour se rendre compte de l’ampleur du phénomène, regardons un peu ce qu’il s’en dit dans la presse.

L’intelligence artificielle dans les médias

Recherche effectuée le 1er octobre. Réessayez vous ne serez pas déçus

Une simple recherche sur Google Actualités vous montrera à quel point l’intelligence artificielle est invoquée à toutes les sauces. Petite sélection toute fraîche :

- L’intelligence artificielle génère des œuvres d’art qui se vendent (Journal des arts)

- La discrimination par l’IA dans le monde de l’assurance (Forbes)

- Les entrepôts du futur seront gérés par l’Intelligence artificielle (FAQ Logistique)

- Voyage d’affaire : les cartes redistribuées grâce à l’intelligence artificielle (LeMonde)

et pour finir mon préféré : - L’Intelligence Artificielle pourrait générer 13 billions de $ d’après Mc Kinsey (LeBigData)

Notez que je n’ai pas fait particulièrement d’efforts dans la sélection, c’est “juste” la première page de Google Actualités. Et elle est renouvelée à un rythme impressionnant.

Mais alors, c’est quoi l’intelligence artificielle (vraiment) ?

Définir l’IA est une des difficultés de la (non)compréhension du sujet.

Les informaticiens, les statisticiens, les marketeux, les politiques et le grand public en auront (au moins) 5 définitions différentes.

Et de là naît une bonne partie du flou et du fantasme autour de ce domaine.

Rajoutez de la peur, des clichés, un bon paquet d’anglicismes (deep learning, neuronal networks, machine learning, etc) qui sont mélangés à tors et à travers sans qu’en général leurs auteurs n’en saisissent le début, vous avez tous les ingrédients pour un gloubi-boulga incompréhensible.

Si je devais choisir une définition, je reprendrais (en la complétant) la définition de Dominique Pastre, professeur d’informatique honoraire à Normale Sup (la partie entre crochet est de mon cru).

L’Intelligence Artificielle (IA) est la science dont le but est de faire faire par une machine des tâches que l’homme accomplit en utilisant son intelligence [mais sans indiquer à la machine comment la réaliser].

La notion d’intelligence réside précisément dans le fait que la machine/le programme est rentré dans une démarche d’apprentissage, pour accomplir une tâche spécifique, sans qu’on ait eu besoin de lui donner la recette.

La raison du boom de l’intelligence artificielle

Le concept d’Intelligence Artificielle et ses premières tentatives d’application ne sont pas nouveaux. On commence d’ailleurs à voir apparaître la notion de cybernétique et les premiers réseaux neuronaux dans les années 1950. La difficulté de l’exploitation de ces concepts réside dans la puissance de calcul nécessaire à leur mise en pratique à grande échelle. Et c’est pour cela qu’après une phase d’enthousiasme (vous avez déjà codé en Lisp ?  ) le domaine n’a réellement explosé qu’avec l’arrivée ces dernières années de machines beaucoup plus puissantes et permettant aux traitements à base d’IA d’être plus performants que de bons vieux algorithmes vieux comme Hérode (ou presque) et longs à coder.

) le domaine n’a réellement explosé qu’avec l’arrivée ces dernières années de machines beaucoup plus puissantes et permettant aux traitements à base d’IA d’être plus performants que de bons vieux algorithmes vieux comme Hérode (ou presque) et longs à coder.

C’est ce qu’explique très brillamment David Louapre de la chaîne Science Étonnante (encore lui !) dans sa vidéo sur le Deep Learning (où il balaye aussi les autres champs de l’intelligence artificielle). Cette vidéo est également une très bonne introduction sur ces concepts parfois un peu ardus.

Les conditions pour qu’une IA fonctionne bien

Si l’on dépasse les fantasmes d’une IA contrôlant le monde – et tous les humains dans une simulation informatique (coucou @ElonMusk) – l’IA a “besoin” de 2 ingrédients pour fonctionner correctement :

- Une tâche spécialisée à réaliser

- Un apprentissage porté par des données massives suffisantes

et un petit bonus : utilisation du bon type d’algorithme, mais nous ne nous attarderons pas dessus.

Application à une tâche spécifique

L’Intelligence Artificielle est en général assez efficace pour fonctionner dans un cadre d’application très précis. Et c’est principalement dû à la nécessité de l’apprentissage (nous en parlerons juste après). Ainsi, si les capacités d’analyses de données de deux systèmes fonctionnant à base d’intelligence artificielle semblent proches (comme les deux exemples d’analyses de flux vidéo ci-dessous le montrent), il est complètement impensable de les inter-changer (leur finalité et leur apprentissage ayant été faits sur des données radicalement différentes).

Exemple n°1 : génération de code HTML automatique sur base de Wireframes dessinés sur un tableau blanc

Ici on voit une personne dessiner un wireframe (ou une interface simplifiée d’un site web) au crayonné, filmé par une caméra qui détecte automatiquement les principaux motifs pour les convertir en direct en code HTML, donc (presque) en site web.

Il y a clairement de l’intelligence artificielle dedans, en particulier pour la reconnaissance de motifs dans la vidéo et les convertir en concepts d’interfaces. J’ai davantage de doutes sur la partie génération de code et responsive, qui est quelque chose d’assez peu complexe une fois les éléments reconnus.

https://www.blig.fr/wp-content/uploads/sites/3/2018/10/1507940147251-drlcss.mp4(source : LinkedIn via Mahendra Singh Chouhan)

Exemple n°2 : reconnaissance vidéo d’un environnement de conduite (@Tesla)

Vidéo plus connue d’une voiture Tesla et de sa reconnaissance en live des éléments de son environnement de conduite : panneaux de signalisation, autres véhicules, piétons, etc. Encore une fois, beaucoup d’IA dans l’analyse des vidéos (couplées aux technologies embarquées sur la voiture) pour savoir différencier un sac plastique poussé par le vent d’un piéton au bord de la route.

Cette spécificité d’application liée à l’apprentissage (et sans remettre en question quelque prouesse technologique) fait que l’Intelligence Artificielle multi-tâche, omnipotente et pouvant contrôler le monde n’existe pas encore (et n’existera probablement pas avant quelques temps), n’en déplaisent aux vendeurs d’angoisse.

Apprendre en masse et très rapidement

L’intelligence artificielle ne fait d’une certaine manière “que” reproduire un processus d’apprentissage très ciblé qu’un enfant peut avoir – sans la même approche pédagogique – mais à vitesse accélérée. Si ce n’est qu’au lieu de faire des lignes d’écritures ou des kilomètres de tables de multiplication, vous lui donnez à manger des données (plus ou moins brutes, plus ou moins structurées) en très grandes quantité. Mais pas pas n’importe quelles données.

En effet, il vous faudra indiquer à l’algorithme (ou aux algorithmes si vous souhaitez les mettre en concurrence) quelles sont les données qu’il doit réussir à reconnaître (tout seul) dans la masse :

- prospects chauds vs prospects froids,

- patients sains vs patients malades,

- un panneau de signalisation,

- un visage,

- etc.

- Le système connaît la réponse pour le premier

Il sert à vérifier que vous n’êtes pas un robot - Le système a un doute sur le second

Votre réponse lui sert à apprendre… à moindre coût

Ainsi, qu’il s’agisse de reconnaître des animaux, du texte ou des devantures de magasins, vos réponses alimentent en données les algorithmes d’Intelligence Artificielle en qualifiant les données.

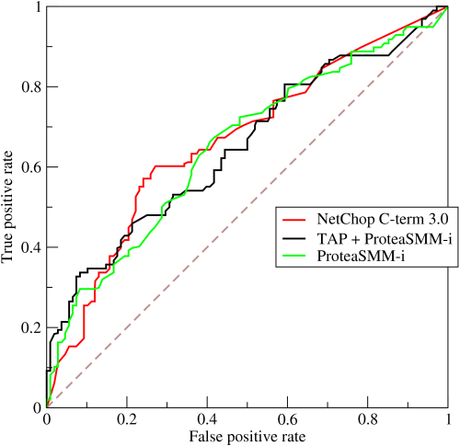

Une fois que l’algorithme a appris, vous pouvez le tester à l’aveugle sur un jeu important de données avec un échantillon témoin, puis vous comptez les faux positifs et les faux négatifs qu’il détecte (les faux positifs étant des résultats faussement bons, les faux négatifs étant des résultats bons mais que l’algorithme n’a pas détecté).

Vous pouvez d’ailleurs comparer les algorithmes en traçant une courbe de ROC (le meilleur algo possible donnant une courbe à angle droit, la courbe moyenne équivalent au hasard : il va sans dire qu’il faut au moins faire mieux que le hasard !).

La courbe ROC de trois estimateurs d’épitope (source Wikipedia).

Exemple n° 1 : apprendre à détecter les anomalies de la rétine

Google a en effet développé un algorithme capable de diagnostiquer rapidement des maladies oculaires. Mais il n’a été capable de le faire qu’avec la participation de médecins qui avaient au préalable indiqué si ces scanners correspondaient à des patients sains ou malades. L’algorithme est donc complètement incapable – même après apprentissage – de comprendre pourquoi ces patients sont malades, ni même pourquoi il les classe en “malade” ou “sain”. Mais par apprentissage des modèles “sains” et “malades” il sait extrapoler sur de nouveaux clichés (et en général avec une marge d’erreur bien plus faible que celles de chirurgiens expérimentés qui peuvent laisser passer certains détails).

Exemple 2 : apprendre à jouer au jeu de go par AlphaGo

Celles et ceux d’entre vous qui s’intéressent au jeu de Go savent que c’est un jeu très difficile à “IAiser“, sans commune mesure aux échecs par exemple, car le nombre de combinaisons est monstrueusement supérieur. C’est notamment pour cela que ce jeu a longtemps résisté aux machines et que les humains y avaient encore la supériorité.

En deux étapes et en quelques années, le laboratoire de Google (DeepMind) a fait sauter ces barrières.

- Tout d’abord en apprenant à une IA avec des milliers de parties jouées par des humains (des bons, hein)

C’était AphaGo - Puis d’une seconde version capable d’apprendre seule… sans les humains

AlphaGo Zero

C’est cette seconde version qui est encore plus bluffante. Partant d’une feuille blanche et des règles de base du jeu de Go, elles s’est entraînée contre elle-même sans relâche, en faisant progresser son niveau, pour apprendre elle-même les meilleures stratégies, certaines étant même assez déstabilisantes pour des joueurs humains.

Pour rebondir sur la spécificité de l’apprentissage : si AlphaGo bat à plate couture les meilleurs champions du monde, il est probable que je lui mette haut la main la misère aux échecs ou aux dames (du haut de mon niveau pitoyable, cela va sans dire). Il est calibré pour le Go et ne comprendrait rien à un autre jeu.

Les pièges de l’IA dans le marketing

Comme personne n’y comprend rien (et c’est malheureux) mais que l’IA génère des fantasmes, de nombreux opportunistes se sont dit qu’on pourrait en faire de l’argent (cf. les prédictions de McKinsey évoquées plus haut).

Devant tant de merveilles, les oreilles des Directions Digitales ou Marketing (ie : vous !) frétillent. Il n’en faut pas plus pour que les solutions se multiplient, toutes meilleures les unes que les autres (cf. 20 outils indispensables du Responsable Digital #Cuvée2018).

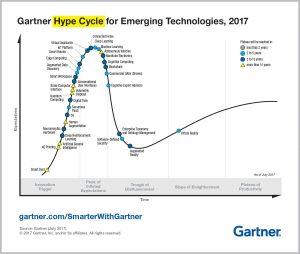

Gartner Emerging Technologies 2017

Les promesses sont souvent les mêmes :

- des performances miraculeuses dans votre champ d’activité (marketing, de distribution, de logistique, etc.)

- du travail réalisé tout seul qui s’améliore avec le temps,

- générer de la valeur avec les données,

- une expérience client personnalisée,

- et même un peu de nouveautés technologiques (c’est à la mode) piochées dans le Gartner Hype Cycle for Technlogies (voir ci-contre) :

- assistant vocaux,

- domotique,

- objets connectés,

- blockchain,

- réalité augmentée,

- etc.

Je grossis volontairement un peu le trait en mettant dans le même sacs de bons et de mauvais produits, mais sachez que la plupart des vendeurs d’intelligence artificielle dissimulent en général un algorithme d’une complexité très basique (au mieux quadratique – cf. analyse de la complexité des algos) ou un bête scoring, ce qui est tout sauf de l’intelligence artificielle. Il n’y a qu’à regarder le jeu de données qu’ils utilisent pour nourrir leurs algorithmes. Creusez les critères d’apprentissages, pour souvent découvrir le pot aux roses.

Donc on jette l’intelligence artificielle à la poubelle ?

Non ! Et si vous vous intéressez à l’IA c’est que l’analyse des données est importante pour vous, et c’est une bonne nouvelle.

Seulement, vous n’êtes peut-être pas encore prêts pour toutes ces innovations, ou en tout cas, l’intelligence artificielle n’est peut-être pas la bonne manière d’y entrer.

Par exemple :

une start-up vous propose de lutter contre la fraude dans votre domaine, de détecter les fraudeurs et donc de vous faire économiser plein d’argent.

C’est une excellente idée en soi (de lutter contre la fraude).

Mais vérifiez que ces quelques éléments sont à votre disposition :

- une bonne vision de vos clients (CRM, outil de gestion, etc.) dans l’idéal avec une vision 360 (omni canal) et unifiée (pas de doublons, c’est l’une des astuces pour frauder

) ?

) ? - les données des transaction (contenant potentiellement de la fraude) avec suffisamment de détail ?

par exemple : si vous n’avez pour chaque transaction qu’un numéro de client et un montant c’est un peu court pour détecter des signaux faibles de fraude - un inventaire suffisamment conséquent de fraudes avérées sur une période de temps assez longue

sinon, vous ne pourrez jamais nourrir votre IA pour qu’elle apprenne et détecte les prochaines fraudes.

Or, si vous ne traitiez pas (encore) la fraude manière organisée, vous allez avoir quelques difficultés à initier ce sujet et passer à l’IA dans le même temps.

Alors que lutter contre la fraude se fait très bien sans intelligence artificielle !

Pour filer cet exemple, vous pouvez commencer par

- rassembler deux types de compétences :

- une personne experte des transactions potentiellement frauduleuses (métier)

- une personne experte de l’analyse des données

- les faire travailler en exploratoire (donc de manière artisanale) avec des algorithmes simples (type régressions logistiques ou autres plus adaptés)

- pour détecter les grosses anomalies dans les données

Ce type d’action courte (sur quelques semaines) permet en général de détecter les plus gros fraudeurs, et d’avoir un ROI assez évident. Il permet aussi de mettre en évidence de potentiels biais (comme des dépenses paraissant “louches” mais qui ne le sont pas du tout).

Et vous pouvez tout à fait considérer qu’il n’est pas rentable d’aller plus loin, et ne jamais investir dans de l’IA industrialisée. Ou au contraire vous lancer si les 20% supplémentaires représentent un tel volume que le ROI est évident.

L’euphorie autour de l’IA pose de très bonnes questions

Ces questions ne devraient pas uniquement se poser du fait de l’intelligence artificielle, mais les débats ouverts sont passionnants :

- vie privée, protection des données,

comment garantir un périmètre privée quand toutes nos données sont utilisées pour nourrir des algorithmes ?

- automatisation des tâches à faible valeur ajoutée,

quelles sont les tâches d’une organisation automatisables par de l’IA ou des machines ?

- évolution du travail et rémunération des individus,

quel modèle de rémunération pour un monde qui continue à s’automatiser ? le revenu universel est-il une réponse ?

- répartition dans le monde des acteurs du numérique/digital/IT/NTIC[rayez-les-mentions-inutiles] quels sont les acteurs puissants dans le domaine de l’intelligence artificielle ? Les Etats doivent-ils prendre leur part ? Comment rester indépendants ?

On voit bien que l’IA ici pose davantage de questions éthiques ou sociétales qu’elle n’en résout (et il faut tout de même un petit bagage pour ne pas y répondre de manière simpliste par un : c’est bien ou c’est mal).

L’IA permet également d’accélérer des activités mures

Si mettre de l’IA pour défricher un problème n’est peut-être pas la meilleure des idées, il y a des cas où cela a tout son sens. Les exemples donnés plus haut ne font que le confirmer.

L’intérêt de l’Intelligence Artificielle est que les premières technologies ne coûtent pas. La plupart sont des technologies OpenSource qui fonctionnent – au moins sur des petits volumes – sur des machines tout à fait raisonnables, en tout cas pour les cas d’usages simples des entreprises (on ne parle pas ici d’usages de surveillance organisée à grande échelle comme le propose Palantir Technologies). Et vous pouvez démarrer ces sujets sans débourser des millions d’euros.

Les compétences en revanche sont un peu plus difficiles à trouver. Mais encore une fois : vous n’avez pas besoin d’une armée de DataScientists pour défricher les sujets de l’IA en commençant par les projets les plus générateurs de valeur.

Une IA bien entraînée est parfois la plus performante dans certains domaines

Les progrès technologiques font que plusieurs domaines ont été investis par l’IA, et avec beaucoup de succès. On pensez bien sûr à la reconnaissance d’images ou de vidéos, aux diagnostic médicaux, ou aux véhicules autonomes.

Ne me faites pas dire ce que je n’ai pas dit !

Attention aux biais !

Comme on l’a vu, l’IA ne fonctionne bien que si elle a appris. Et votre jeu de données possède forcément des biais, aussi complet soit-il. Même les expériences encensées d’IBM et de Watson peinent à convaincre dans durée :

“Ce produit est une mer**” a déclaré un médecin de l’hôpital Jupiter en Floride aux dirigeants d’IBM, selon les documents. “Nous l’avons acheté pour le marketing et avec l’espoir que vous réaliseriez la vision. Nous ne pouvons pas l’utiliser dans la plupart des cas.”

IBM Watson et les traitements contre le cancer : c’est pas encore ça, (ZdNet)

Et quand bien même elles fonctionneraient, Watson (l’Intelligence Artificielle d’IBM) n’a été entraîné qu’avec les données de certains hôpitaux. Essayez de l’appliquer sur un service d’oncologie de Pékin ou de de New Dehli, ses résultats seront beaucoup moins performants.

Petite astuce : sortez-vous de la tête d’éviter les biais, c’est quasiment impossible. Par contre, détectez vos biais et challengez votre IA régulièrement pour vérifier que son apprentissage ne dévie pas et reste aligné aux données à jour.

3 bonus pour aller plus loin

J’en arrive au bout de ce trop long article sur l’IA (mais que j’avais envie d’écrire depuis longtemps). Le sujet est beaucoup trop large pour avoir tout traité. Et ce qui l’a été l’est probablement de manière très incomplète et imparfaite. N’hésitez pas à utiliser les commentaires plus bas ou sur les réseaux sociaux pour me reprendre ou entamer la discussion !

Pour celles et ceux qui veulent aller plus loin, je vous propose 3 bonus pour votre besace ou vos heures perdues.

Le Podcast TechCafé

Si vous ne connaissez pas (encore !) TechCafé, courrez-vite vous y abonner (techcafe.fr). Je ne recommande pas ce podcast parce que j’y participe de temps à autres, mais parce que son contenu est d’une grande qualité, notamment grâce aux deux Guillaumes qui y font un très grand travail de veille et de vulgarisation.

TechCafé ne parle pas à chaque fois d’Intelligence Artificielle (mais régulièrement), et je vous mets 2 épisodes qui parlent plus spécifiquement du sujet :

60. Fails d'intelligence artificielle et les smartphones de demain (ou pas)

Gardez un oeil sur Numerama

J’ai beaucoup cité Numérama tout au long de ce billet mais leurs prises de paroles sont très justes, très sourcées et très peu putaclic. Si vous avez un doute sur un sujet Tech, allez lire ce qu’ils en disent, c’est un très bon filtre.

Je vous renvoie en particulier à l’excellente chronique de @Vinvin sur Numerama :

À lire sur Numerama : Bullshit Thérapie : ne flippez pas, l’intelligence artificielle n’existe pas

Le Bingo de détection du bullshit de l’IA

Petit clin d’oeil humoristique pour finir, un petit bingo sur le thème de l’IA. Si une start-up coche trop de cases d’un coup en avant-vente, restez vigilants !

Ça y est, j'ai enfin bouclé mon Bullshit Bingo sur l'intelligence artificielle. Il devrait fonctionner pour pas mal d'articles, de documentaires et de conférences à venir… pic.twitter.com/IPpwk21uhg

— Erwan Cario (@erwancario) November 10, 2017

Source @ErwanCario via NextINpact

References [ + ]

1. ↑ source : Larousse : http://www.larousse.fr/encyclopedie/divers/intelligence_artificielle/187257

L’article Intelligence Artificielle : révolution ou supercherie ? est apparu en premier sur Blig !.