Quand on travaille sur un sujet de pointe comme l’Intelligence Artificielle, on entend souvent une quantité de fantasmes, de ponctifs, de prédictions ou de cris d’alarme sur ce sujet. Il faut pourtant garder la tête froide, car même si le monde va vite, il ne va pas dans la direction que beaucoup nous montrent…

Je me bats toute la journée contre des prédicateurs qui nous annoncent un futur tantôt désespérément optimiste (et, il faut bien le dire, chiant), tantôt totalement alarmiste. Dès que cela concerne l’IA, la machine à fantasmes fonctionne à plein. Il suffit que qu’une machine batte un humain à un jeu consistant à pousser des cailloux sur un damier pour que l’on entende un nombre invraisemblable de conneries.

AlphaGo est beaucoup plus bête qu’un joueur de Go moyen

Je commencerais bien par rappeler que l’IA telle qu’on la pratique aujourd’hui est très, très, très (très) loin d’égaler l’humain dans quelque tâche que ce soit. Revenons-en à AlphaGo, qui a monopolisé beaucoup l’attention et les angoisses.

Pour mémoire, Deep Mind est un programme informatique qui a d’abord étudié des milliers (millions ?) de parties humaines, puis qui a été modifié pour fonctionner en “circuit fermé” en apprentissage par renforcement, en jouant contre lui-même environ 5 millions de parties. Fantastique.

Rappelons qu’une partie de Go dure environ 1h. Imaginons qu’un joueur commence à 5 ans, et joue 10 heures par jour, 365 jours par an, ce qui est déjà plus qu’énorme. Le meilleur joueur du monde, Lee Sedol, a 35 ans. À ce rythme il a potentiellement joué un maximum de 10x365x30 = 109.000 parties.

Tant qu’AlphaGo n’aura pas été capable de s’entrainer sur 100.000 parties, on ne pourra pas dire qu’il dépasse l’humain en intelligence sur ce jeu.

Quand on y songe, cela fait des années que l’on sait faire la différence entre la puissance de calcul et la puissance de réflexion (à mettre entre gros guillemets) d’un programme. Je suis incapable de faire de tête le calcul “8341/539” quand la calculette à moins d’1€ sur mon bureau me donne la réponse avec plein de chiffres après la virgule.

N’empêche : j’ai beau essayer d’expliquer un problème de maths niveau CP à ma calculatrice, elle ne sait rien faire d’autre que me donner le résultat d’opérations simples que je lui indique.

Eh oui, c’est ça, un programme : ça prend des données en entrée, ça fournit des données en sortie, et l’AI ce n’est rien qu’un programme informatique. AlphaGo prend en entrée un état du plateau de jeu et fournit en sortie le mouvement à effectuer. Conceptuellement, c’est plutôt simple et limité — même si une fois encore il ne s’agit pas de minimiser l’incroyable effort de recherche pour parvenir à ce résultat.

Le progrès n’est pas linéaire mais asymptotique

“Oui mais demain”, me direz-vous, “nous disposerons de programmes informatiques et de calculateurs capables d’effectuer des choses plus compliquées etc”. Oui mais non. Pourquoi ? Parce que l’évolution naturelle d’une technologie n’est pas infiniment linéaire.

Prenons la création du véhicule automobile dans son état au début du XXème siècle. Nos aïeux imaginaient alors que les véhicules attendraient des vitesses de plus en plus élevées, voire voleraient assez rapidement, et il en est ainsi de toutes leurs caractéristiques techniques : on imaginait que le rythme du progrès resterait le même, alors qu’il s’épuise.

Lors de l’émergence d’une technologie, les progrès sont rapides, car il reste tant à défricher et de nombreux paramètres permettent d’influer sur la performance de la technologie. Plus cette techno est adoptée, plus sa recherche est financée, plus les découvertes sont enchainées et plus le coût d’une augmentation de la performance augmente. Sans parler de l’atteinte des lois physiques pour certains domaines. Même la loi de Moore s’essouffle !

Il en est d’ailleurs de même pour les domaines sportifs : l’évolution des records du 100m masculin suit grosso modo une progression logistique et pas linéaire, ce qui laisse présager qu’une limite existe, et surtout que les progrès sont de plus en plus difficiles à accomplir.

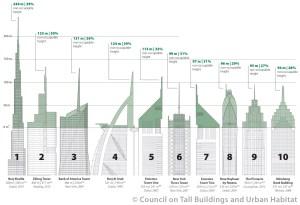

Même chose pour les gratte-ciels… On peut décliner les exemples à volonté. Et donc — même chose pour l’AI telle que nous la connaissons aujourd’hui, qui, bien que toujours en évolution spectaculaire, atteindra forcément un plateau évolutif en attendant que d’autres technologies ne prennent le pas.

1984 n’a pas ressemblé à 1984

Lorsque l’on écoute les prédictions de certains qui se basent sur l’évolution d’une technologie pour extrapoler et prédire notre futur, il faut se méfier et démasquer ces naïfs (au mieux) ou manipulateurs. Prévoir le futur, ce n’est que de la science fiction. Si j’avais su prévoir l’essor du BitCoin il y a ne serait-ce que 5 ans, je serais aujourd’hui en situation d’envoyer une voiture sur Mars !

Bah non. Prévoir le futur d’un point de vue social ou sociétal en se basant sur l’évolution présente d’une technologie, c’est de la science-fiction. Et que nous dit la science fiction ?… Il suffit de se pencher dans des œuvres ultra-célèbres pour s’en rappeler !

- 1984 a été écrit par Orwell en 1948 et nous sommes très, très loin de ce monde (on peut toujours disserter sur certains aspects métaphoriques, mais politiquement et technologiquement on en est loin).

- Blade Runner était censé se dérouler en 2019. Ok, il reste un an, mais pour l’instant nous n’avons ni voitures volantes, ni usines à cyborgs indiscernables des humains. Allez, maintenant, relisez donc ce que l’on nous prédit du futur sur la base d’expérimentations plus ou moins hasardeuses… On en reparle dans dix ans !

- 2001, l’odyssée de l’espace, sorti en 1968. Toujours pas de colonie sur la lune, toujours pas d’exploration de Jupiter, et bien sûr toujours pas de Hal 9000. Et pourtant, le film était particulièrement bien documenté !

On ne peut généraliser sur la base d’exemples, mais mis à part certains points de détails, je ne connais pas beaucoup de prévisionnistes qui aient vu juste du point de vue de l’évolution technologique. A-symp-to-tique, vous dis-je. Avec de temps en temps un petit bon en avant. L’iPhone a révolutionné l’usage du téléphone cellulaire, mais depuis l’iPhone 1 il y a dix ans, l’évolution tant chez Apple que chez ses concurrents reste tout de même très très modérée.

La dure loi du marché

Dernier point, l’évolution technologique se heurte (violemment) à l’intérêt qu’elle présente pour ses clients. Et les nombreux fondateurs de start-ups persuadés d’avoir conçu le produit du siècle et qui se heurte à l’absence totale de réponse des consommateurs savent de quoi il en retourne !

Et, quelque part, le meilleur d’obtenir les crédits nécessaires pour financer la recherche technologique, c’est encore d’avoir un marché… Et nous, les utilisateurs, têtus comme nous sommes, en faisons bien ce que nous voulons !

Oh, ce petit commentaire humoristique date de 2013. Some things never change!