IMAGE : ISABEL ESPANOL

NEWS NEWS NEWS. Entre octobre 2014 et janvier 2015, un robot d’achat en ligne, le Random Darknet Shopper, a acheté au hasard sur le « Web profond » – non indexé par les moteurs de recherche –, parmi d’autres denrées, dix pilules d’ecstasy, des copies de jeans Diesel et un faux sac Vuitton. Ces objets, payés en bitcoins, ont été présentés à Saint-Gall, en Suisse, lors d’une exposition par les deux artistes helvètes qui ont lancé le robot (ou « bot »). L’un d’eux, Carmen Weisskopf, a expliqué qu’ils voulaient montrer la simplicité de l’accès aux marchés illégaux du Web, mais aussi soulever la question de la responsabilité des robots intelligents. En effet, qui incriminer pour l’achat de la drogue et des faux ? Les deux artistes, qui ont lancé cette recherche aléatoire sans savoir ce que le bot allait acheter ? Ou le logiciel qui a mené ces opérations illégales ? (enquête publiée dans Le Monde Idées)

Le porte-parole de la police suisse, qui a fait saisir et détruire l’ecstasy, a déclaré qu’il ne poursuivrait pas les deux artistes car la drogue n’était pas destinée à être consommée ni vendue, et parce qu’ils ne savaient pas ce que le « shopper » allait acheter. Quant au robot, il n’a pas été incriminé. Ces décisions ont été beaucoup commentées par tous ceux, industriels, avocats, juristes, qui réfléchissent sur les problèmes juridiques complexes posés par l’arrivée massive de robots dotés d’intelligence artificielle (IA). Ainsi, un professeur de droit de l’université de Washington, Ryan Calo, a étudié l’affaire. Il estime que les deux artistes, en attendant « délibérément » que le bot trouve des denrées illégales sur le Web profond, sont responsables des actes illicites commis. Selon lui, ils ont manifesté une « intention » coupable et relèvent de ce que le droit anglo-saxon nomme le mens rea, l’esprit criminel intentionnel, un facteur essentiel pour établir une culpabilité.

Sur la responsabilité du robot, Ryan Calo avoue en revanche une certaine perplexité. Aujourd’hui, le droit distingue toujours clairement une machine – un objet sans intentionnalité – d’une personne – un sujet responsable. Or, avec l’émergence d’une robotique douée d’IA et d’autonomie, ces deux notions, reconnaît-il, « s’amalgament ».

Problèmes juridiques complexes

Ryan Calo n’est pas le seul juriste, peu s’en faut, à s’intéresser à l’épineuse question de l’adaptation du droit à la nouvelle robotique. Et à réfléchir sur l’urgence de légiférer. En juin par exemple, un rapport du Parlement européen constatait que « l’humanité se trouve à l’aube d’une ère où les robots, les algorithmes intelligents, les androïdes et les autres formes d’intelligence artificielle, de plus en plus sophistiqués, semblent être sur le point de déclencher une nouvelle révolution industrielle », et se désolait de l’absence de cadre juridique pour traiter ce phénomène. En Europe, en effet, les robots intelligents industriels relèvent actuellement des directives « machines » du droit du travail, qui doivent garantir un haut niveau de sécurité et de conformité aux normes (basse tension, comptabilité électromagnétique, etc.). Mais rien de plus.

En France aussi, où plusieurs articles du code du travail réglementent les obligations des machines (sécurité, bon fonctionnement, ergonomie, etc.), le vide juridique concernant des robots autonomes et intelligents interpelle autant les industriels de la robotique que les spécialistes du droit. Voilà pourquoi pour pallier ce manque, le Syndicat des machines et technologies de production (Symop), qui regroupe 270 entreprises affiliées à la Fédération des industries mécaniques, a rendu public, le 25 octobre, un Livre blanc consacré à l’élaboration d’un nouveau « droit de la robotique ». Pour ses rédacteurs, du fait de l’omniprésence des robots dans les entreprises, à l’hôpital et dans les transports, il y a urgence.

Le Therac-25, une machine de radiothérapie responsable d’au moins six drames, dont quatre mortels. DR

Un logiciel mis en cause

Prenons un cas d’école : l’affaire du Therac-25, une machine de radiothérapie contre le cancer pilotée par ordinateur. Entre 1985 et 1987, au Canada et aux Etats-Unis, elle a été associée à au moins six drames, dont quatre mortels, au cours desquels les patients ont reçu des doses massives de radiation. Il fallait établir les responsabilités. L’enquête de justice et les expertises ont finalement conclu à une série d’« accidents » dus à des dysfonctionnements informatiques.

Bien sûr, plusieurs fautes humaines ont été relevées : par exemple, la société chargée de la commercialisation du nucléaire civil au Canada, l’Energie atomique du Canada limitée (EACL), n’a pas fait évaluer le code source du logiciel du Therac-25 par un organisme indépendant, et a négligé de tester toutes ses étapes d’utilisation. Mais c’est malgré tout le logiciel qui a été mis en cause : il ne détectait pas le dysfonctionnement du faisceau d’électrons, qui irradiait les patients sans cibler leur tumeur. Le système de sécurité de la machine reposait uniquement sur ses analyses, tandis que des problèmes d’« incompatibilité » entre certains programmes se succédaient, générant des bugs informatiques.

Trop de mains levées

Une professeure de droit de l’université de New York, Helen Nissenbaum, a analysé ce jugement dans un texte qui fait aujourd’hui référence, « La responsabilité dans une société informatisée » (Science and Engineering Ethics, 1996, vol. 2). Elle synthétise la question posée par l’affaire du Therac-25 en une formule : il aggrave « le problème juridique des nombreuses mains levées ». Si nous sommes habitués à rendre responsable d’un délit une unique personne – celle qui, idéalement, lève la main pour se dénoncer –, il est toujours difficile de déterminer les responsabilités personnelles d’un drame ou d’un accident quand on a affaire à un collectif : une grande entreprise dirigée par une structure collégiale, une administration publique ou militaire menée par un conseil, là où les décisions se prennent à la majorité, impliquant certains dirigeants plutôt que d’autres, à la tête d’une longue chaîne de responsabilité.

Or, explique cette juriste, ce problème de la multiresponsabilité est compliqué par l’arrivée de robots intelligents. Car la plupart des logiciels ont été conçus puis fabriqués par « diverses entreprises, agences ou même des universités » – soit autant de coresponsables possibles en cas de dysfonctionnement.

Par ailleurs, les systèmes informatiques sont eux-mêmes construits à partir de « plusieurs segments et modules », qui peuvent provenir de différentes équipes. Ajoutons que certains programmes numériques « incluent parfois des versions de code antérieures » imaginées par d’autres personnes – d’où des « incompatibilités » imprévisibles quand ils sont assemblés. C’est cette multiplication des fabricants et des fonctions techniques – ces « plusieurs mains levées » –, présente dans l’affaire du Therac-25, qui rend très difficile l’attribution des responsabilités.

Faut-il pour autant, s’interroge Helen Nissenbaum, renoncer à exercer le droit et se contenter de répertorier des « accidents sans agents » ? Prenons les bugs informatiques. Nous en sommes arrivés, dit-elle, à les considérer comme des « accidents inévitables »associés au fonctionnement même des ordinateurs, considérés comme intrinsèquement « vulnérables ».

Un accident de voiture sans chauffeur : aucun cadre juridique n’est encore prévu. DR

« Erosion de la responsabilité »

Cette conception nous amène à penser qu’il serait « déraisonnable de tenir pour responsables des dysfonctionnements des systèmes les programmateurs, les ingénieurs et les concepteurs du high-tech ». Faut-il accepter cette nouvelle « érosion de la responsabilité » du fait de la complexité et de l’autonomie de la robotique ?

Dans A Legal Theory for Autonomous Artificial Agents (« Une théorie juridique pour les agents artificiels autonomes », University of Michigan Press, 2011, non traduit), le philosophe du droit Samir Chopra, de l’université de New York, et l’avocat Lawrence F. White donnent d’autres exemples de cette dilution de la culpabilité en cas de dysfonctionnement des robots. Ils montrent comment, dans nombre de métiers – voyagistes, banques, gardiennage, conseil en ligne (parfois médical) –, les humains sont remplacés par des bots. En cas d’erreur (défaut bancaire, billet d’avion antidaté, réponse absurde en boucle, mauvaise prescription), le public a de plus en plus tendance à rendre le robot responsable.

Cela s’explique par le fait qu’il est le médiateur direct : le premier « antécédent causal ». En droit anglo-saxon, il est le prima facie, le responsable de premier abord. Il est donc blâmé. Mais comme il n’a aucun statut juridique, sa responsabilité est écartée – et du coup, personne n’est responsable. Un véritable droit des robots, avancent les deux auteurs, devrait remédier à ces situations.

FAUT-IL, S’INTERROGE LA JURISTE HELEN NISSENBAUM, RENONCER À EXERCER LE DROIT ET SE CONTENTER DE RÉPERTORIER DES « ACCIDENTS SANS AGENTS » ?

Helen Nissenbaum, qui milite aujourd’hui pour la défense de la vie privée sur Internet malmenée par des algorithmes, donne des précisions sur ce que devraient être ces nouvelles « lois de la robotique » – pour reprendre l’expression de l’écrivain de science-fiction Isaac Asimov. Si le coupable « devient insaisissable » dans les affaires de robot défectueux ou fautif, il reste, rappelle-t-elle, que des chefs d’entreprise ou d’une administration ont bien décidé de remplacer leurs employés ou leurs fonctionnaires par des robots.

Selon elle, l’absence de responsabilité directe – par exemple pénale – d’un constructeur ou d’un dirigeant du fait de l’action imprévue d’un robot ne signifie pas que ces personnes « ne doivent pas rendre des comptes sur leurs produits » – ce qu’elle appelle l’« accountability » –, ni « répondre aux questions » sur leurs choix – ce qu’elle nomme l’« answerability ». Au-delà de la responsabilité juridique, estime-t-elle, il existe une responsabilité sociale dont ils sont redevables.

DR

« Imprévisibilité »

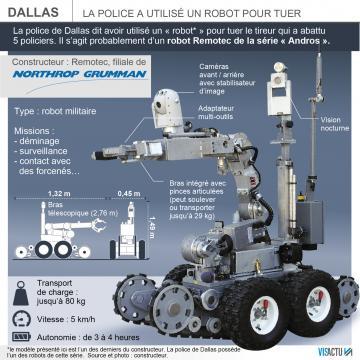

Cette dilution de la responsabilité n’est pas la seule interrogation soulevée par la nouvelle robotique. En juillet 2015, des grands noms de l’IA se sont associés à la campagne menée par l’association Human Rights Watch contre les projets de « robots tueurs » : des armes autonomes capables de choisir leurs cibles et de les abattre.

Un de ses porte-parole est Peter Asaro, professeur à l’Ecole des études médiatiques à la New School (New York). Il estime que déléguer la responsabilité de tuer à un robot est contraire aux droits de l’homme. Il s’intéresse aussi à l’éthique des machines et à leur « imprévisibilité » associée à l’autonomie des nouveaux robots industriels. C’est pour lui une donnée nouvelle, que le droit doit étudier de près.

En effet, remarque-t-il dans un texte publié en mars par l’Association pour l’avancement de l’intelligence artificielle, le fabricant d’un produit ne doit pas mettre en vente des objets imprévisibles, risquant d’être dangereux. S’il a connaissance du problème, et veut éviter d’être condamné, il doit « raisonnablement » le prévoir, estimer les risques, prévenir le public par un mode d’emploi, etc.

Or, l’arrivée de machines intelligentes s’attelant d’elles-mêmes à des tâches non programmées, apprenant grâce au deep learning, rend désormais possibles des actions imprévisibles – que personne n’a « vraiment voulues ». Une mitrailleuse (militaire ou de police) choisissant elle-même ses cibles décide de tirer sur un enfant ou un homme portant un drapeau blanc. Une voiture sans chauffeur écrase un passant plutôt que d’emboutir un arbre. Un logiciel achète de l’ecstasy.

LES FABRICANTS ET LES PROPRIÉTAIRES DE ROBOTS POURRAIENT SE RETROUVER DANS LA SITUATION DE « PERSONNES POSSÉDANT DES ANIMAUX SAUVAGES »Peter Asaro avance qu’accorder aux robots intelligents un statut de « personnalité juridique », comme le conseille le Parlement européen, serait un pas en avant. Cela permettrait d’identifier et de préciser les responsabilités en cas de faute du bot.

Le juriste avance que les fabricants et les propriétaires de robots se retrouveront alors dans la situation de « personnes possédant des animaux sauvages », c’est-à-dire imprévisibles : ils seront tenus pour responsables de leurs actions et devront se préparer en conséquence. Il leur faudra verser des dommages et intérêts aux victimes, prendre des assurances (lesquelles exigeront de revenir à plus de prudence et de réduire la part d’imprévisibilité des robots)…

L’éthique des machines

A Paris, l’avocat Alain Bensoussan, l’un des auteurs du Livre blanc sur le droit des robots, avance une série de recommandations proches. La première est la création d’un « comité national d’éthique de la robotique » qui étudierait les relations entre l’homme et les robots intelligents et l’intégration de ceux-ci dans la vie quotidienne.

D’autres préconisations suivent : intégrer des « boîtes noires » dans les robots pour en comprendre les dysfonctionnements, étudier les nouvelles possibilités d’accidents, réfléchir aux questions d’assurance et de certification.

Comme M. Asaro, cet avocat pense qu’il y a urgence à attribuer aux robots un statut de « personnalité juridique ». Et appelle à la création d’un « commissariat aux algorithmes » qui régulariserait leurs usages – aujourd’hui hors de contrôle.

Nous nous retrouverons bientôt, croit Peter Asaro, face à un dilemme : soit nous adopterons un « principe de précaution » avec les robots, en limitant leur autonomie et contrôlant leur intelligence, tout en publiant leur code source pour que chacun apprenne à les manœuvrer ; soit nous choisirons une « approche permissive », en laissant l’innovation se déployer dans tous les domaines. Et en assumant le risque de vivre avec des robots autonomes, capables de réaliser des prodiges, mais aussi de mener des actions dangereuses et criminelles.

- Frédéric Joignot