Des chercheurs de l’Indiana et du Portugal veulent mettre au point un algorithme capable de vérifier la véracité des informations disponibles sur le net.

Et si l’algorithme devenait le meilleur allié du journaliste à l’heure où la course au scoop et l’information en continu grandissent ? Dans ce contexte, un algorithme qui vérifierait automatiquement les faits semble tentant. Cela serait loin d’être complètement irréaliste selon un article de l’université d’Indiana aux États-Unis associée à l’Institut Gulbenkian de Ciencia au Portugal. Une équipe de six chercheurs a tenté de mettre au point un tel outil. Car face à la masse des informations fournies par le net, distinguer le vrai du faux devient une tâche de plus en plus ardue. D’où l’idée de créer un système qui écarterait des recherches les résultats erronés, complotistes ou simplement loufoques.

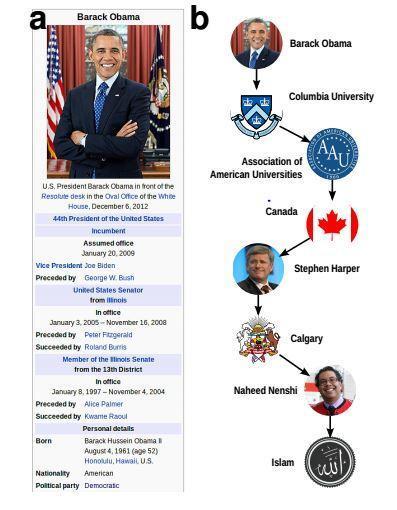

Le principe de l’algorithme créé par l’équipe de chercheurs est a priori simple : il s’agit de reprendre les “graphiques de connaissances” (ou “knowledge graph” un peu à la manière de celui de Google). Ici le système sépare dans une phrase le sujet, l’objet et le verbe. L’article prend ainsi l’exemple de l’assertion “Socrates / est une / personne.” Même si la place du déterminant paraît grammaticalement contestable dans cette distribution, l’idée est bien d’étudier les liens qui unissent sujet et objet. Tous deux sont des nœuds du système créé. Ces nœuds sont ensuite reliés par les différents verbes. Le tout forme ainsi des graphiques complexes. Les chercheurs ont relié sur ce principe plusieurs sujets à partir de Wikipédia. Pour déterminer le caractère exacte d’une phrase comme “Barack Obama est musulman.” ils ont ensuite établi le lien entre le sujet (Obama) et l’objet (musulman). Plus le chemin est long et complexe entre les deux éléments de la phrase, moins l’affirmation a de chances d’être exacte. C’est le cas pour cet exemple.

Pour vérifier une information, il suffirait avec un tel graphique, de considérer le lien plus ou moins direct entre un sujet et un objet. Le travail même de vérification de l’information serait grandement facilité. Certains imaginent même un plugin sur Chrome qui trierait automatiquement les résultats non vérifiés des recherches grâce à cet algorithme faisant remonter les liens les plus avérés. À tel point que chacun serait en fait un peu journaliste dès lors qu’il effectuerait une recherche sur le web. Le travail du journaliste en deviendrait automatique ; non sans conséquences sur le métier. On assistait déjà à des formes de “crowd-checking” mais ce serait une étape de plus vers un tri automatisé de l’information sur Internet. Les chercheurs pensent même que de tels systèmes pourraient “atténuer les effets sociétaux des nouvelles formes de désinformation” s’ils étaient développés à plus large échelle.

Malgré tout, l’algorithme est en butte à un problème majeur auquel font également face de nombreux projets de langage artificiel : les pièges de la langue. Ironie, métaphores, hyperboles, métonymies, etc. sont quelques unes des nuances qu’un modèle mathématique peut difficilement envisager. Reste à voir si ce que les chercheurs ont pour l’instant testé sur le seul Wikipédia (considéré comme une source fiable par l’article) peut être appliqué à l’ensemble du net.