Partager la publication "Test A/B – les 10 erreurs à éviter pour fiabiliser et améliorer ses résultats"

Voici les 10 erreurs les plus souvent commissent lors de tests AB.

Voici les 10 erreurs les plus souvent commissent lors de tests AB.

Attention, toute ressemblance avec des actions ou des situations réelles n’est pas fortuite ! Imprégnez-vous de ces infos pour renforcer la fiabilité de vos tests et améliorer vos résultats et enseignement. Surtout que la majorité des erreurs de test A/B sont très simples à éviter… C’est parti !

Bien entendu, en cas de besoin, le webAnalyste peut vous aider à mettre en oeuvre votre processus de test AB.1. Déclarer prématurément la version gagnante d’un Test A/B.

La fiabilité ou la confiance statistique vous indique si votre test est statistiquement fiable, si la version A est réellement meilleure que la version B, si la taille de l’échantillon est suffisamment grande.

5o% de fiabilité statistique correspond à un tirage au sort. Pile ou face.

75% de fiabilité statistique n’est pas suffisant, 25% de chance de se tromper, c’est trop risqué.

Il arrive quelquefois que des versions « gagnantes » à 80% de confiance statistique finissent par faire moins bien en augmentant leur part de trafic.

90% de confiance statistique, c’est bon ? Non,ce n’est pas suffisant non plus. On cherche des résultats qui soient scientifiquement valides, qu’il soient vrais, reproductibles. Ce qui est plus important que de déclarer un vainqueur, c’est de déclarer le véritable vainqueur.

En tant qu’optimiser, votre travail consiste à comprendre la vérité. Vous devez mettre votre ego de côté. C’est très humain de s’attacher à votre hypothèse, et ça peut être délicat lorsque vos meilleures hypothèses finissent par ne pas être sensiblement différentes. Les tests AB exigent de placer la vérité au-dessus de tout, sinon ça n’a plus de sens.

Un scénario très commun, même pour les entreprises qui testent beaucoup : ils conduisent un test après l’autre pendant 12 mois en déployant les versions gagnantes. Un an après, le taux de conversion de leur site est le même que quand ils ont commencé les tests. Ça arrive très souvent.

Pourquoi ? Parce que les gagnants des tests AB sont déclarés trop tôt et/ou la taille des échantillons est trop petite. Vous ne devez pas valider un test AB avant qu’il soit atteint 95% ou plus. Ça signifie qu’avec 95% de fiabilité statistique il y a seulement une chance de 5% que les résultats soient le fruit d’un coup de chance.

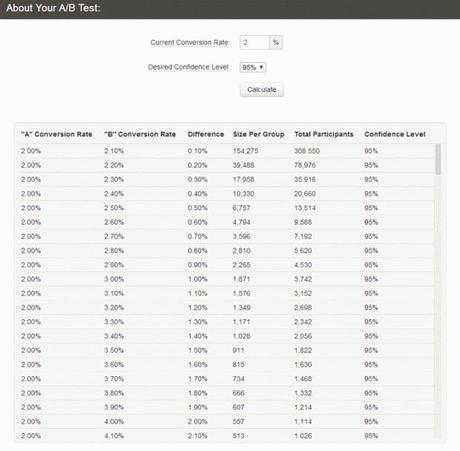

Quelle taille doit avoir mon échantillon de visiteur pour lancer un test AB ?

Bien entendu, vous ne devez pas tirer des conclusions sur la base d’un échantillon de petite taille. Je recommande de viser au moins 100 conversions par variation avant de regarder la confiance statistique. Si vous avez beaucoup de trafic, aller au moins jusqu’à 250 conversions par variations.

Il y a certains cas où l’on peut anticiper la désignation d’une version gagnante d’un test AB, mais pour cela, vous aurez besoin de taux de conversion élevés et d’un écart important entre les résultats des différentes variations. Vous pouvez estimer le nombre de visiteurs dont vous aurez besoin pour vos tests en utilisant cet outil : http://www.testsignificance.com

Que faire si j’ai 100 (ou 250) conversions par variation, et la fiabilité statistique n’est toujours pas 95% (ou plus) ?

Cela signifie qu’il n’y a pas de différence significative entre les variations. Vérifiez les résultats des tests avec chaque segment pour vérifier si la fiabilité a été réalisée par l’un des segments. En tout cas, vous avez besoin d’améliorer votre hypothèse et lancer un nouveau test.

2. Exécuter des tests AB sur des périodes de moins de 7 jours.

Imaginons que vous avez un site à fort trafic. Vous obtiendrez 98% de confiance et 250 conversions par variation en 3 jours. Le test est-il plié ?

Non !

Nous devons éliminer les effets de saisonnalité et tester sur des semaines complètes. Si vous lancez un test un lundi, il devra être terminé un lundi. Pourquoi ? Parce que votre taux de conversion peut varier considérablement en fonction du jour de la semaine.

Donc, si vous ne testez pas sur une semaine complète, vous biaisez les résultats. Utilisez un rapport personnalisé pour lister les conversions par jour de la semaine et mesurer ainsi les fluctuations.

Comme vous pouvez le constater dans l’exemple ci-dessous, durant la période donnée, les écarts de vente entre les jours de la semaine sont importants. Par exemple, on constate 2 fois plus de transactions, le mardi et le mercredi que les autres jours de la semaine.

Si nous ne conduisons pas les tests sur des semaines complètes, les résultats seront inexacts. Donc, vous devez toujours conduire vos tests sur des cycles de 7 jours. Si la confiance statistique n’est pas atteinte (95%+) dans les 7 premiers jours, exécuter un autre cycle de 7 jours. Si au bout de 14 jours, la fiabilité n’est pas obtenue, exécuter un nouveau cycle de 7 jours. Le seul moment où vous pouvez passer outre cette règle, c’est lorsque vos données historiques révèlent un taux de conversion similaire entre le jour de la semaine.

Faites toujours attention aux facteurs externes.

Est-ce Noël ? Votre gagnant d’un test pendant les vacances de fin d’année ne le serait peut-être pas en janvier. Si vous avez des gagnants pendant la saison des achats comme Noël, où l’engagement est plus fort que d’ordinaire, vous devez absolument retester vos variations gagnantes une fois la saison des achats terminée. De la même manière, une importante campagne télé, radio, presse, web peut fausser vos résultats. Pour éviter d’avoir à retester votre hypothèse, tenez-vous informé des actions de votre entreprise.

3. Exécuter un test AB, même quand ils n’ont même pas de trafic (ou de conversions).

Si vous faites 1 ou 2 ventes par mois, et exécutez un test où B convertit 15% de mieux que A – comment pouvez-vous le savoir ? Rien ne change!

J’aime les tests AB, c’est un outil extraordinaire pour optimiser durablement ses résultats, mais ce n’est pas quelque chose que vous devez utiliser pour l’optimisation de conversion si vous avez très peu de trafic. La raison en est que, même si la version B fait beaucoup mieux, cela pourrait prendre plusieurs mois pour atteindre le taux de 95% de fiabilité statistique.

Ainsi, s’il faut 5 mois pour valider statistiquement votre test, vous aurez perdu beaucoup de temps et d’argent. Au lieu de cela, vous devriez aller droit au but, opter pour des changements massifs. La démarche est la même, identifier la métrique à améliorer, identifier une hypothèse, puis au lieu de passer par un test, vous dupliquez la page A (qui servira de backup en cas de marche arrière), vous adaptez la copie pour en faire votre page B avant de la déployer en prod. Une fois en ligne suivez de près les écarts entre les versions A et B de la page avant et après la modification. L’idée est d’avoir des taux d’amélioration importants (lifts) – comme 50% ou 100%.

Le temps c’est de l’argent. Ne perdez pas de temps à attendre un résultat de test qui prend plusieurs mois. Soyez agile, allez de l’avant !

4. Exécuter un test qui n’est pas fondé sur une hypothèse.

Lorsque vous testez des idées au hasard, juste pour voir si ça fonctionne, c’est comme jeter un spaghetti sur un mur pour voir s’il est cuit.

Tester des idées aléatoires peut au final vous coûter cher et vous faire perdre un temps précieux. C’est donc à éviter. Vous avez besoin d’une hypothèse.

wikipédia : « Une hypothèse est une proposition ou une explication que l’on se contente d’énoncer sans prendre position sur son caractère véridique, c’est-à-dire sans l’affirmer ou la nier. Il s’agit donc d’une simple supposition, appartenant au domaine du possible ou du probable. Une fois énoncée, une hypothèse peut être étudiée, confrontée, utilisée, discutée ou traitée de toute autre façon jugée nécessaire, par exemple dans le cadre d’une démarche expérimentale. »

Vous ne devriez pas émettre des hypothèses « au petit bonheur la chance ». Chercher plutôt comment faire en sorte d’augmenter le nombre de personnes sur 100 qui achètent, comment améliorer la rétention des landing pages, comment améliorer l’engagement et la fidélité des utilisateurs, comment améliorer l’étanchéité du processus de commande, comment augmenter la récence, la fréquence et la valeur moyenne des clients.

En résumé, cherchez à déterminer quel est l’indicateur le plus important à améliorer aujourd’hui pour votre entreprise, avec le ratio gain/effort le plus haut possible. Une fois que vous avez déterminé cette métrique, formulez votre hypothèse : si Qui (le segment) fait Quoi (l’action), Parce Que (la motivation), cela améliorera la métrique cible.

Lisez l’article le Cycle Lean Analytics pour optimiser vos conversionsImaginez que vous testez A vs B sans réelle hypothèse et que B gagne avec 15%, c’est super, youppi, mais qu’avez-vous appris de cette expérience ? Rien. Augmenter les conversions, c’est le but des tests AB, mais ce qui est encore plus important, c’est ce que nous en savons plus sur notre audience. Cela nous aide à améliorer notre connaissance client. Des informations inestimables pour alimenter nos futures hypothèses de tests comme les futures actions marketing de l’entreprise, voir à plus haut niveau alimenter un système d’apprentissage automatique pour générer des prédictions (à tester).

5. Ne pas envoyer les données à Google Analytics ou autres.

Rappelez-vous que si A bat B de 10%, ce n’est pas l’image complète. Vous devez segmenter les données du test, pour mettre à jour de nouvelles idées.

Tous les outils de tests proposent une option pour interfacer les tests avec Google Analytics, donc assurez-vous de l’avoir paramétré.

Une fois configuré, le serveur de test envoie les informations à Google Analytics sous la forme de variables personnalisées et d’événements. De cette manière, vous pourrez créer des segments avancés et des rapports personnalisés. C’est indispensable, c’est la seule façon d’extraire des informations exploitables de vos tests AB (y compris des tests qui échouent ou qui ne font pas la différence ).

6. Gaspiller un temps précieux et du trafic pour tester des évidences.

Vous testez les couleurs, hein ? Arrêtez.

Il n’y a pas de meilleure couleur, il est toujours question de hiérarchie visuelle. Bien sûr, vous pouvez trouver des exemples de tests en ligne qui démontre des gains en changeant simplement la couleur d’un bouton, mais il s’agit souvent d’évidence. Ne perdez donc pas votre temps à tester l’évidence, changer de couleur directement. Utilisez votre trafic pour tester des hypothèses qui bougent les lignes et qui vous en apprennent plus sur vos clients et potentiels clients.

7. Abandonner après un premier test qui échoue.

Vous mettez en place un test…. et il échoue. Eh bien. Essayons d’exécuter des tests sur une autre page ?

Pas si vite ! La plupart des premiers tests échouent. C’est vrai. Je sais que vous êtes impatient, tout comme moi, mais en vérité, la clé du succès est dans l’itération des tests. Vous exécutez un test, vous tirez des leçons pour améliorer votre connaissance client et vos hypothèses. Vous exécutez un nouveau test, vous tirez de nouvelles leçons pour améliorer votre connaissance client et vos hypothèses. Vous exécutez un nouveau test…,et ainsi de suite.

Les tests sont un moyen d’échouer rapidement à moindres frais. Un échec est utile, si vous en faites quelque chose. Donc ne vous mettez pas la pression, un test même s’il échoue est riche d’information, exploitez-les pour affiner votre connaissance client et modifier ou changer d’hypothèse. On ne gagnera pas d’argent sur un test, c’est dans la conduite de tests itératifs que l’argent est. Maintenant, vous savez où se trouve le trésor, devenez ou recrutez un CROpro pour miner vos filons.

8: Ne pas comprendre les faux résultats positifs.

La fiabilité statistique n’est pas la seule chose à faire attention. Vous devez comprendre les faux résultats positifs. Les testeurs impatients voudront sauter les tests A / B, et passer aux tests A / B / C / D / E / F / G / H. CA vous parle maintenant !

C’est vrai pourquoi se contenter de tester simultanément 2 versions, Google a bien testé 41 nuances de bleu ! OK, mais ce n’est pas une bonne idée. Plus vous avez de variations à tester les unes contre les autres, plus vous augmentez le risque de faux résultats positifs. Dans le cas des 41 nuances de bleu, même avec au niveau de confiance à 95%, le risque de faux résultats positifs est de 88%.

Regardez cette vidéo, vous allez apprendre une chose ou deux :

En résumé, évitez de tester trop de variations à la fois. Il est préférable de faire des tests A/B simples, de toute façon vous obtiendrez des résultats plus rapidement et vous apprendrez aussi rapidement comment améliorer ou revoir votre hypothèse au final, vous risquez de gagner plus d’argent en itérant plus de tests. Par ailleurs, c’est beaucoup plus simple d’analyser les facteurs du succès ou de l’échec entre deux versions qu’entre 3, 4 ou plus.

9. Exécuter simultanément plusieurs tests.

Vous avez un site e-commerce, et vous pensez que vous êtes un génie. Vous pensez avoir trouvé un chemin de traverse en exécutant plusieurs tests en même temps. Un sur la page du produit, un sur la page du panier et l’un sur la page d’accueil. Est-ce un gain de temps ?

Non. Vous biaisez les résultats. Si vous voulez tester une nouvelle version de plusieurs mises en page à la fois, comme la page produit, le panier et le checkout, vous devez exécuter un test multi-page conçu pour tester un ensemble de pages, comme un tunnel de conversion, de façon cohérente. De cette manière, les personnes voient soit la nouvelle ou l’ancienne version de chaque page.

10. Ignorer les petits gains.

Votre version B a battu la version de contrôle A de 4%. « Bha, c’est beaucoup trop faible comme un gain! Je ne vais pas perdre du temps à l’implémenter »..

Disons les choses directement :

- Si votre site est assez bon : vous n’allez pas avoir des lifts (gain) élevés tout le temps. En fait, les lifts élevés sont très rares.

- Si votre site est nul, il est facile d’exécuter des tests qui lift à 50% tout le temps.

La plupart des tests gagnants donnent des petits gains : 1%, 5%, 8%. Parfois, un lift de 1% peut entraîner des millions d’euros de recettes. L’important, c’est de mettre en perspective les lifts sur 12 mois.

Un test est juste un test. Vous allez faire beaucoup, beaucoup de tests. Si vous augmentez votre taux de conversion de 5% chaque mois, au final cela fera un lift de 60% sur 12 mois. Et 60%, c’est énorme !

N’oubliez jamais que ce sont toujours les petites rivières qui font les grandes rivières.

11. (Bonus) Ne pas exécuter de tests tout le temps.

Chaque jour sans un test est une journée de perdue. Tester c’est apprendre. Apprendre sur votre audience, apprendre sur ce qui fonctionne et pourquoi. Toutes ces informations peuvent vous être utiles dans vos actions marketing online et offline.

Vous ne savez pas ce qui fonctionne jusqu’à ce que vous le testez.

Avoir un test qui tourne tout le temps ne signifie pas que vous devez tester tout et n’importe quoi. Absolument pas. Comme on l’a vue précédemment (point 4 et 6), vous devez toujours chercher à valider une hypothèse qui vise l’amélioration d’un indicateur crucial, aujourd’hui, pour votre entreprise (gagnez de l’argent/économiser de l’argent/améliorer la satisfaction client).

Testez, testez, testez et gagnez à tous les coups. Si vous cherchez un point de départ pour mettre en place un processus, regardez cet article Cycle Lean Analytics pour optimiser vos conversions et également le sCROm.

Cet article a été inspiré par celui de Peep Laja.Partager la publication "Test A/B – les 10 erreurs à éviter pour fiabiliser et améliorer ses résultats"

Attention, toute ressemblance avec des actions ou des situations réelles n'est pas fortuite..." itemprop="description" />