Il fût une grande époque du marketing et des marchés test, nous souvenons nous des Assessor et autres Perceptor qui fondaient d’une certaine manière les bases du Marketing Science, dont les travaux abondants se trouvent dans la revue éponyme et font les délices de Journal of Marketing Research. Ce fut les années 70. A l’heure des hippies, le marketing science naissait.

Ce rêve ou ce fantasme, a été pour les chercheurs en marketing, de rassembler toutes les sources de données imaginables, pour mesurer et évaluer une fonction fondamentale du marketing mix.

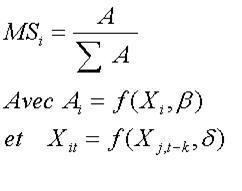

Cette fonction est relative à la part de marché de la marque i (MSi) qui est fonction de l’effort Ai qu’elle fournit au regard de l’effort fourni par l’ensemble de ses concurrents. Cet effort étant lui-même fonction des différents efforts fournis en termes de qualité de produit, de communication, de promotion, de marketing direct, de prix et de toutes les autres variables d’action Xit, et de leur efficacité relative beta. Ce modèle de base pouvant être complété par les fonctions de réaction, chaque action de l’un entraînant des réactions des autres(Xj, t-k). Il est

peu de dire qu’une immense littérature s’est développée autour de cette équation fondamentale, et que celle-ci sans réduire toutes les facettes des problèmes à modéliser en est la matrice fondamentale.

peu de dire qu’une immense littérature s’est développée autour de cette équation fondamentale, et que celle-ci sans réduire toutes les facettes des problèmes à modéliser en est la matrice fondamentale.Une des plus grandes opportunités offerte par ce mouvement a été l’apparition dans l’industrie des biens de grande consommation du développement du scanning. Avec les lecteurs de code barre le marketing research a connu une nouvelle époque.

Dans ce contexte, une des sources de données les plus intéressantes de ce point de vue sont les marchés tests « single source » qu’on construit des groupes tels que GfK avec sa filiale MarketingScan qui entretient BehaviorScan, IRI ou Nielsen dans les années 80. Il s’agit d’un double dispositif, à savoir d’un panel de consommateurs combiné avec un outil de mesure de l’audience média qui permet de regrouper des données d'achats et des facteurs d'influence marketing (exposition à tous types de medias, promotions des points de ventes, marketing direct), et d’un panel distributeurs. Le grand intérêt est de permettre théoriquement de mesurer directement les effets et l’efficacité d'actions marketing ou publicitaires sur les comportements d'achat (comportement d’achat individuel, comme les taux de premier achat et achat répété, le switching ainsi que la duplication d’achat, puis le CA, et les part de marchés).

L’intérêt de ce dispositif a été et est bien évidemment inestimable à la fois pour les chefs de produits, responsable marketing ou chargés d’études pour s’assurer du véritable retour sur investissement des campagnes publicitaires, comme pour les universitaires et chercheurs pour comprendre les phénomènes de marché. Ils ne promettaient pas moins qu'un changement révolutionnaire en terme de méthodologie de mesure d’efficacité d’actions marketing. Cependant, ils ont contribué également à des débats les plus controversés entre universitaires et le lobby des publicitaires. On se souviendra des fameux publications de Leonard Lodish (1995a[1] et 1995b[2]) dans Marketing Science et dans Marketing Science (How TV Advertising Works: A Meta Analysis of 389 Real-World Split-Cable TV Advertising Experiments."), sur l’efficacité publicitaire sur le court et long terme réalisés à partir des données single source BehaviorScan. Lui et son équipe ont a été les premiers à utiliser à grande échelle les données single source et de remettre en question des préjugés établis par le lobby des publicitaires. Il contribuera notamment à répondre à la fameuse question “I know that only half of my advertising works; I just don't know which half”.

Malheureusement, l’avenir prometteur de ce type de dispositif a été freiné par une polémique sur la façon dont ces données devraient être employées. Les promoteurs, surtout des universitaires, préconisaient l'utilisation de ces données comportementale pour l'optimisation des campagnes TV, les adversaires, des publicitaires et annonceurs, étaient pour une approche classique de segmentation par l’emploi de données démographiques. L'industrie n'était visiblement pas encore prête à un changement de mesure d’efficacité média au delà d'une quantification de la valeur de leurs produits en termes de variables démographiques.

Et les défenseurs des données de single-source pouvaient seulement voir la valeur intrinsèque des données comme contraste à ce qui pourrait être renseigné sur des assistances de TV par l'analyse seuls des profils démographiques. L'industrie de publicité a finalement voté contre les données single-source à cette époque, préférant la description à l’explication causale. Sans doute ont-il voulu protéger leur business. Cependant, la bouteille a été ouverte et les mauvais esprits s’en sont échappés. Le phénomène panel single source ne pouvait plus être arrêté.

La prolifération de ce type de données est évidente aujourd'hui, débordant les seuls aspects de la publicité : marketing direct, promotion, cartes de fidélité, megabases, une multitude de sources fait sourdre des torrents de données, qui se fondent en un fleuve d’information.

Les annonceurs ainsi que les distributeurs les emploient pour trouver des réponses à toutes les facettes de la planification marketing (i.e. optimisation budget publicitaire, lancement de nouveaux produits, campagne marketing direct, catégorie management). Nous ne parlons pas seulement des universitaires américain, mais de plus en plus européens qui se sont appropriés ces terrains d’études phénoménales pour donner des réponses à des problématiques de recherche en marketing.

Une des entreprises les plus actives dans le domaine est GfK, avec sa filiale MarketingScan qui entretient le panel « single source » BehaviorScan avec un panel de consommateurs (9000 foyers) qui permet de regrouper des données d'achats et des facteurs d'influence marketing (exposition à tous types de medias, promotions des points de ventes, marketing direct) et un panel distributeurs (24 grandes surfaces) à Angers et au Mans. Le marché test BehaviorScan est une méthodologie d’étude, utilisée en Europe aujourd’hui par les plus grands annonceurs de la grande consommation (Coca Cola, Danone, Ferrero, General Mills, Kellogg’s, Kraft Foods, L’Oréal, Nestlé France, Orangina – Schweppes, Procter & Gamble, Unilever, Yoplait pour ne citer que quelques uns) dans trois pays : Etats-Unis, Allemagne et France.

Plus de 700 études, apportant des réponses précises à des problématiques aussi diverses que le lancement d’un nouveau produit, la modification d’un élément du mix marketing d’une marque existante, le test d’une nouvelle stratégie média ou la mesure de l’efficacité d’une opération de marketing direct, témoignent du énorme succès des panels single source.

Des questions telles que :

- une distribution de prospectus permet-elle de recruter de nouveaux clients ?

- quel est l’impact d’une tête de gondole sur le niveau de consommation ?

- un produit gratuit contribue-t-il e à la fidélisation à la marque ?

- une animation en magasin génère-t-elle une anticipation d’achat ou une augmentation durable de la consommation ?

- quel est le potentiel d’un nouveau produit ?

- quelle est l’éventuelle cannibalisation par rapport aux produits existants ?

- quel est l’apport du nouveau produit à la catégorie ?

- quel monitoring de lancement ?

y trouvent une réponse quantifiable.

Cependant, aujourd’hui de nouveaux enjeux d’études de marché se dessinent. La grande vague marketing orienté client avec des programmes de fidélisation distributeurs crée des nouvelles sources de données « micromarketing » à un niveau magasin.

A cela s’ajoute que la communication se fait plus diffuse serpentant dans les méandres du fleuve internet. Moins que la part de marché la valeur client devient de plus en plus l’indicateur de mesure dominant. Et les marchés tests « single source » qui étaient un « laboratoire isolé » devient aujourd’hui une sources de données parmi d’autres.

Quelles sont alors les perspectives pour l’avenir ?

Une évolution méthodologique sera certainement la fusion entre les dispositifs de panel avec les bases de données des magasins et les informations des annonceurs, permettant de compléter les informations panel décrites plus hautes par celles des programmes de fidélisation et des actions marketing. Un projet va dans ce sens aux Etats-Unis, où des entreprises intersectorielles (Kraft Foods, IBM, Information Resources Inc. (IRI), PricewaterhouseCoopers, ACNielsen, quelques distributeurs et Catalina Marketing) se sont regroupées dans un programme pilote, s’appelant Shopper*Direct, qui relie les données d’achat scannérisées du panel consommateurs HomeScan (55.000 foyers américains) à celles provenant des points de ventes des distributeurs.

Une autre projet similaire est la collaboration entre d’un côté le panelist Nielsen, l’entreprise de conseil média Arbitron Inc., et de l’autre côté des annonceurs comme Procter & Gamble, Unilever, Kraft, Johnson & Johnson, SC Johnson, Wal-Mart et Pepsi-Cola. Cependant, ce dernier projet a été récemment abandonné pour des raisons de coûts (investissement jusqu’à présent : plus de 30 millions de $ !!).

L'évolution technique s'inscrit sans doute dans le développement des système d'identification, au code-barre dont le rôle a été essentiel, risque de succéder le RFID dont on peut penser qu'il va systématiser cette culture de la mesure, de la modélisation, et du contrôle de la performance marketing.

Quant à l'évolution du marketing research, il est fort à penser que plus que la part de marché, compte-tenu des changement de stratégies marketing, c'est à dire l'évolution vers un marketing orienté client, ce sont des indicateurs tels que la Life-time value qui risque d'être au centre de l'effort de modélisation. Ce sera l'objet de la scéance du workshop TiM du 13 mars 2008.

Lars Meyer-Waaden, Université Toulouse III.

Références Bibliographiques

[1] Lodish, L.M., Abraham, M, Kalmenson S, Livelsberger J. et al. (1995), “How T.V. advertising works: A meta-analysis of 389 real world split cable TV Experiments ”, Journal of Marketing Research, 32, 2.125-39.

[2] Lodish, L.M., Abraham, M, Livelsberger J., Lubetkin B et al. (1995), “A summary of fifty-five in-market experimental estimates of the long-term effect of TV advertising”, Marketing Science, 14, 3, 2. G133-141.