La nouvelle est apparue dans un des nombreux sujets de discussion du centre webmaster de Google : le moteur de recherche vérifie et intègre le contenu d'un sitemap de plus en plus souvent si celui-ci est mis à jour régulièrement.

- A quelle vitesse Google indexe votre sitemap ?

En d'autres termes, plus votre sitemap se met à jour souvent, plus Google réduira le temps entre chaque lecture de ce fichier.

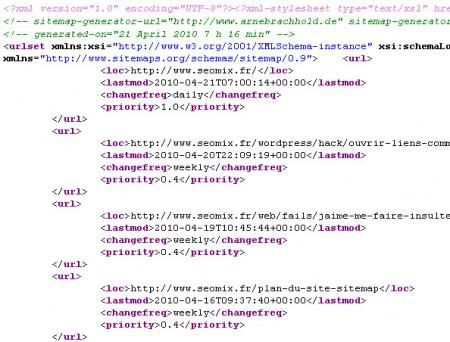

Comment Google index votre sitemap ?

Un sujet de conversation a été lancé par un webmaster de site, qui a constaté que Google accédait 14 800 par jour aux fichiers sitemaps de ces 375 domaines différent, soit près de 40 accès par jour pour chaque site Internet (ce qui est, soit-dit en passant, n'est pas si élevé que cela). Sa problématique était donc de comprendre comment le crawl fonctionnait, le tout pour réduire la charge de son serveur.

Joh'n Mu, un des salariés de la société, indique donc :

Le Crawl des sitemaps par Google dépend directement de la fréquence de la mise à jour de vos fichiers sitemaps. Si nous trouvons un nouveau contenu à chaque crawl, il est probable que nous indexions plus souvent votre fichier sitemap.

Il nous explique ensuite comment réduire la vitesse de crawl sur un serveur (ou sur un ensemble de serveurs) :

Si vous limitez votre mise à jour de sitemap à une fois par jour (ou toute autre fréquence que convient à votre activité), cela peut aider à réduire la fréquence de crawl.

De même, vous pouvez créer un fichier sitemap partagé entre plusieurs sous-domaines. Cela peut aider à réduire le nombre de requêtes envoyées par Google pour chacun de ces domaines.

Le fichier n'a pas nécessairement vocation à être sur le même hébergeur ou domaine que le site lui-même. Si nous indexons trop souvent votre site, vous pouvez également choisir la vitesse de crawl dans le centre webmaster.

Le concept est donc identique au crawl d'un site web : plus un site est mis à jour souvent, plus Google reviendra vite.

Mais si vous avez des soucis de serveur, je vous conseillerais plutôt d'en changer, plutôt que de chercher à freiner les moteurs de recherche...

Petites remarques en passant :

- un crawl = une lecture, et non pas une indexation. Si Google crawle une page, il ne va pas forcément l'indexer dans le moteur de recherche (robots.txt, contenu dupliqué, ...)

- je ne comprends pas l'intérêt de réduire une vitesse de crawl. Théoriquement, plus elle est élevée, plus vous référencez rapidement vos nouveaux contenus, non ? Si l'un de vous y trouve un intérêt, qu'il m'explique pourquoi...

Pour ajouter votre sitemap à votre fichier robots.txt, utilisez tout simplement le code suivant :

Code block

Sitemap: http://www.mondomaine.fr/sitemap.xml

En savoir plus sur l'indexation de Google

- Source : Google Crawls Sitemap File Based On Update Frequency

- Le Sujet de conversation sur le crawl des sitemaps

- Le centre webmaster de Google