Apple n'a pas encore répondu

Que vient-il de se passer ? Quelques jours seulement après que l'outil de synthèse des notifications d'Apple, basé sur l'IA, ait publié un faux titre de la BBC sur Luigi Mangione, un organisme commercial majeur exhorte l'entreprise à supprimer complètement cette fonctionnalité. Il s'agit du dernier revers dans les tentatives d'Apple pour convaincre ses clients que son IA vaut la peine d'être utilisée.

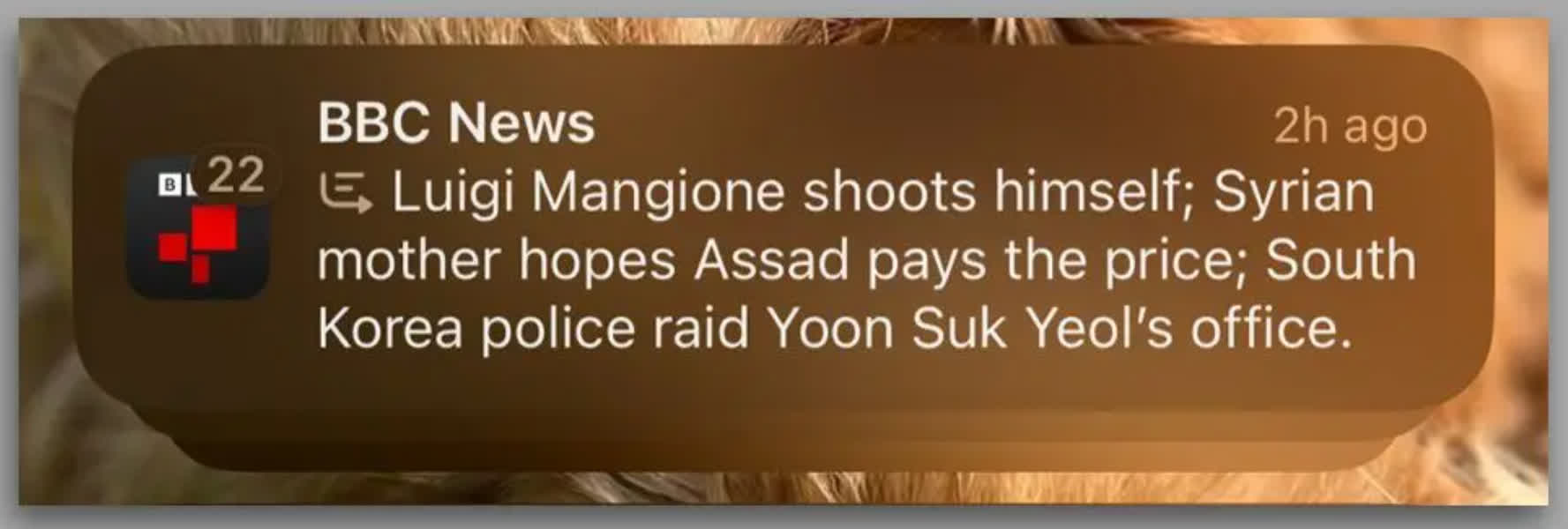

Le 13 décembre, Apple Intelligence, qui a l'habitude de commettre des erreurs importantes lorsqu'il s'agit de résumer les notifications, a publié un résumé de plusieurs titres de la BBC incluant l'affirmation que Mangione s'était suicidé. L'incident s'est produit 48 heures seulement après le lancement d'Apple Intelligence au Royaume-Uni.

Avec l'aimable autorisation de BBC News

Mangione, qui a été arrêté et accusé du meurtre au premier degré du PDG d'UnitedHealthcare, Brian Thompson, à New York, ne s'est pas suicidé. Il est toujours détenu à l'établissement correctionnel de l'État de Huntingdon, dans le comté de Huntingdon, en Pennsylvanie.

Ce n'est certainement pas la première fois qu'Apple Intelligence se trompe dans une notification récapitulative. Il avait précédemment affirmé que le Premier ministre israélien Benjamin Netanyahu avait été arrêté après que la Cour pénale internationale avait émis un mandat d'arrêt.

Reporters sans frontières (RSF), une ONG internationale à but non lucratif qui se consacre à la protection du droit à la liberté d'information, demande à Apple de désactiver la fonction de résumé des notifications.

RSF écrit que cet incident illustre à quel point les services d’IA générative sont encore trop immatures pour produire des informations fiables pour le public et ne devraient pas être autorisés sur le marché pour de telles utilisations.

Le groupe a ajouté que la manière probabiliste dont fonctionnent les systèmes d’IA les disqualifie automatiquement en tant que technologie fiable pour les médias d’information.

« Les IA sont des machines à probabilités et les faits ne peuvent pas être décidés par un coup de dés. RSF appelle Apple à agir de manière responsable en supprimant cette fonctionnalité. La production automatisée de fausses informations attribuées à un média porte un coup à sa crédibilité. et un danger pour le droit du public à une information fiable sur l'actualité, déclare Vincent Berthier, responsable du bureau Technologie et journalisme de RSF.

« La loi européenne sur l'IA – bien qu'elle soit la législation la plus avancée au monde dans ce domaine – n'a pas classé les IA génératrices d'informations comme des systèmes à haut risque, laissant ainsi un vide juridique critique. Cette lacune doit être comblée immédiatement. »

La BBC a contacté Apple lorsqu'elle a eu connaissance du faux titre pour faire part de ses inquiétudes et demander à l'entreprise de résoudre le problème.

La notification sommaire en question montrait trois titres : le faux sur Mangione, et deux titres corrects, sur le renversement du régime de Bachar al-Assad en Syrie et une mise à jour sur le président sud-coréen Yoon Suk Yeol.

Apple affirme que la capacité de synthèse de son IA permet aux utilisateurs d'analyser des notifications longues ou empilées avec des détails clés directement sur l'écran de verrouillage, par exemple lorsqu'une discussion de groupe est particulièrement active. Il se trompe souvent dans les résumés ou ne parvient pas à comprendre leur contexte, parfois de manière hilarante.

La diffusion de fausses nouvelles va toujours causer des ennuis à Apple, surtout à une époque où les entreprises tentent de convaincre les gens que l'IA est l'avenir de presque tout. Apple n'a pas encore répondu à l'incident, mais ne vous attendez pas à ce qu'il supprime définitivement la fonctionnalité. Tout au plus, Cupertino pourrait le désactiver pendant un certain temps.