Maia ne battra probablement pas le H100 de Nvidia dans une course, mais un prix moins cher ne peut pas nuire aux ventes

La vue d'ensemble : Nvidia détient entre 75 et 90 % du marché des puces d'intelligence artificielle. Malgré ou plutôt à cause de cette domination du marché, les grands rivaux technologiques et les hyperscalers ont développé leur propre matériel et leurs propres accélérateurs pour grignoter l'empire de l'entreprise en matière d'intelligence artificielle. Microsoft est désormais prêt à dévoiler les détails de sa première puce d'intelligence artificielle personnalisée.

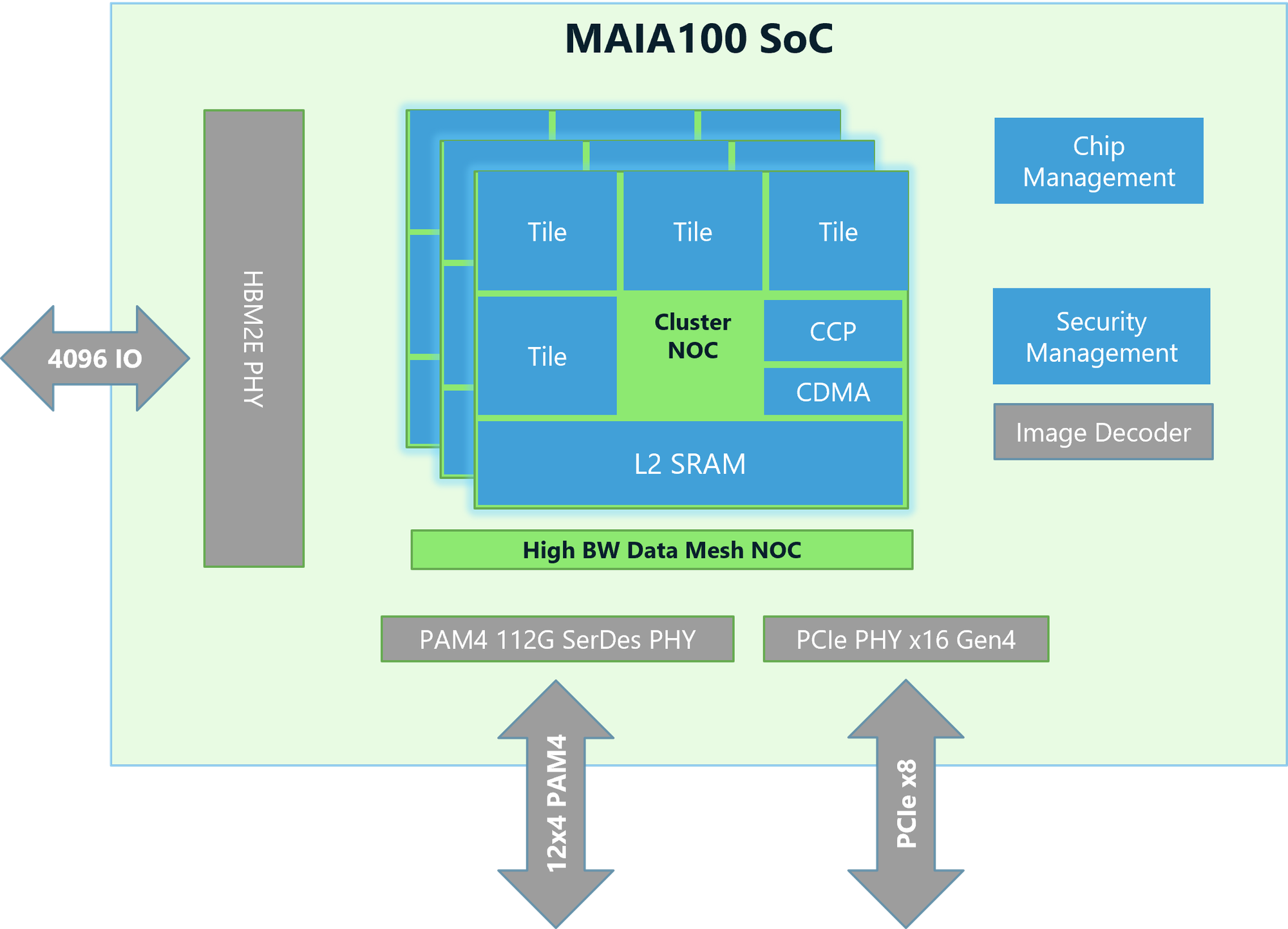

Microsoft a présenté son premier accélérateur d'IA, Maia 100, lors de la conférence Hot Chips de cette année. Il est doté d'une architecture qui utilise des cartes de serveur, des racks et des logiciels personnalisés pour fournir des solutions et des performances améliorées et rentables pour les charges de travail basées sur l'IA. Redmond a conçu l'accélérateur personnalisé pour exécuter des modèles OpenAI sur ses propres centres de données Azure.

Les puces sont construites sur le nœud de processus 5 nm de TSMC et sont fournies sous forme de pièces de 500 W mais peuvent prendre en charge jusqu'à un TDP de 700 W.

La conception de Maia permet de fournir des niveaux élevés de performances globales tout en gérant efficacement la consommation d'énergie globale de la charge de travail ciblée. L'accélérateur dispose également de 64 Go de HBM2E, un niveau inférieur aux 80 Go du Nvidia H100 et aux 192 Go de HBM3E du B200.

Selon Microsoft, l'architecture SoC Maia 100 dispose d'une unité tenseur haute vitesse (16xRx16) offrant un traitement rapide pour la formation et l'inférence tout en prenant en charge une large gamme de types de données, y compris les types de faible précision tels que le format MX de Microsoft.

Il dispose d'un moteur superscalaire faiblement couplé (processeur vectoriel) construit avec ISA personnalisé pour prendre en charge les types de données, notamment FP32 et BF16, un moteur d'accès direct à la mémoire prenant en charge différents schémas de partitionnement de tenseurs et des sémaphores matériels qui permettent la programmation asynchrone.

L'accélérateur d'IA Maia 100 fournit également aux développeurs le SDK Maia. Le kit comprend des outils permettant aux développeurs d'IA de porter rapidement des modèles précédemment écrits dans Pytorch et Triton.

Le SDK comprend l'intégration du framework, des outils de développement, deux modèles de programmation et des compilateurs. Il dispose également de noyaux de calcul et de communication optimisés, du Maia Host/Device Runtime, d'une couche d'abstraction matérielle prenant en charge les lancements de noyau d'allocation de mémoire, la planification et la gestion des périphériques.

Microsoft a fourni des informations supplémentaires sur le SDK, le protocole réseau backend de Maia et l'optimisation dans son article de blog Inside Maia 100. C'est une bonne lecture pour les développeurs et les passionnés d'IA.