Dans la course aux supercalculateurs d'IA, il pourrait y avoir des projets pour un groupe de formation d'IA battant des records

Prospectif : Ce n’est un secret pour personne que Nvidia est le principal fournisseur de GPU pour les centres de données, mais il est désormais tout à fait possible qu’AMD devienne un concurrent sérieux sur ce marché à mesure que la demande augmente. AMD a récemment été contacté par un client lui demandant de créer un cluster de formation d’IA composé de 1,2 million de GPU. Cela le rendrait potentiellement 30 fois plus puissant que Frontier, le supercalculateur le plus rapide actuel. AMD a fourni moins de 2 % des GPU des centres de données en 2023.

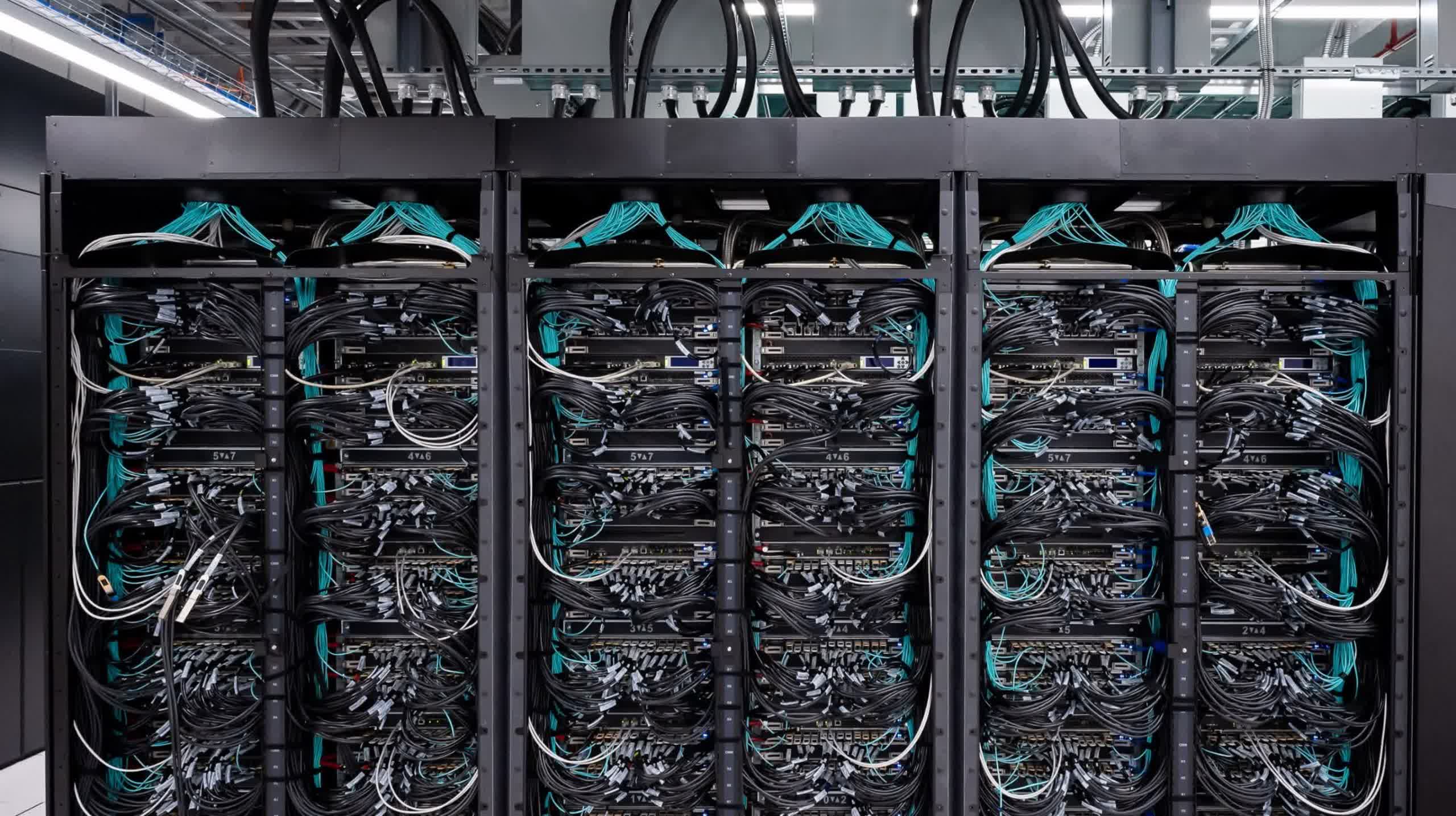

Dans une interview accordée à The Next Platform, Forrest Norrod, directeur général des solutions de datacenter d'AMD, a révélé avoir reçu de véritables demandes de clients pour créer des clusters de formation d'IA utilisant 1,2 million de GPU. Pour mettre cela en perspective, les clusters de formation d'IA actuels sont généralement créés à l'aide de quelques milliers de GPU connectés via une interconnexion à haut débit sur plusieurs racks de serveurs locaux.

L’ampleur envisagée aujourd’hui pour le développement de l’IA est sans précédent. « Certains des groupes de formation envisagés sont vraiment ahurissants », a déclaré Norrod. En fait, le plus grand supercalculateur connu utilisé pour entraîner les modèles d'IA est Frontier, qui possède 37 888 GPU Radeon, ce qui rend le supercalculateur potentiel d'AMD 30 fois plus puissant que Frontier.

Bien sûr, ce n'est pas si simple. Même aux niveaux de puissance actuels, il existe une multitude d’embûches à prendre en compte lors de la création de clusters de formation en IA. La formation à l’IA nécessite une faible latence pour fournir des résultats rapides, consomme des quantités importantes d’énergie et les pannes matérielles doivent être prises en compte, même avec quelques milliers de GPU seulement.

La plupart des serveurs fonctionnent à environ 20 % d’utilisation et gèrent des milliers de petites tâches asynchrones sur des machines distantes. Cependant, l’essor de l’apprentissage de l’IA entraîne un changement important dans la structure des serveurs. Pour suivre le rythme des modèles et des algorithmes d’apprentissage automatique, un centre de données d’IA doit être équipé d’une énorme puissance de calcul spécialement conçue pour cette tâche. L’apprentissage de l’IA est essentiellement une tâche synchrone de grande envergure qui nécessite que chaque nœud du cluster transmette des informations dans les deux sens le plus rapidement possible.

Le plus intéressant est que ces chiffres proviennent d'AMD, qui a représenté moins de 2 % des expéditions de GPU pour centres de données en 2023. Nvidia, qui représentait les 98 % restants, est resté muet sur ce que ses clients lui ont demandé de créer. En tant que leader du marché, nous ne pouvons qu'imaginer sur quoi ils travaillent.

Même si le supercalculateur proposé de 1,2 million de GPU peut sembler farfelu, Norrod a déclaré que des « personnes très sobres » envisagent de dépenser jusqu'à cent milliards de dollars dans des clusters de formation en IA. Cela ne devrait pas être un choc, car les dernières années dans le monde de la technologie ont été définies par l’explosion des progrès de l’IA. Il semble que les entreprises soient prêtes à investir des sommes importantes dans l’IA et le machine learning pour rester compétitives.