L’informatique hyper hétérogène apporte des composants silicium coûteux aux serveurs traditionnels

La grande image: L’activité serveurs devrait atteindre de nouveaux sommets de revenus au cours des prochaines années, et cette croissance n’est pas uniquement attribuée à l’accélération de la charge de travail de l’IA. Selon la société d’études de marché Omdia, les puissants coprocesseurs GPU sont le fer de lance de la transition vers un modèle informatique totalement hétérogène.

Omdia prévoit une baisse pouvant atteindre 20 % des livraisons annuelles de serveurs d’ici fin 2023, malgré une croissance attendue des revenus de 6 à 8 %. Le récent rapport de mise à jour du marché du cloud et des centres de données de la société illustre une refonte du marché des centres de données motivée par la demande de serveurs d’IA. Cela favorise à son tour une transition plus large vers le modèle informatique hyper-hétérogène.

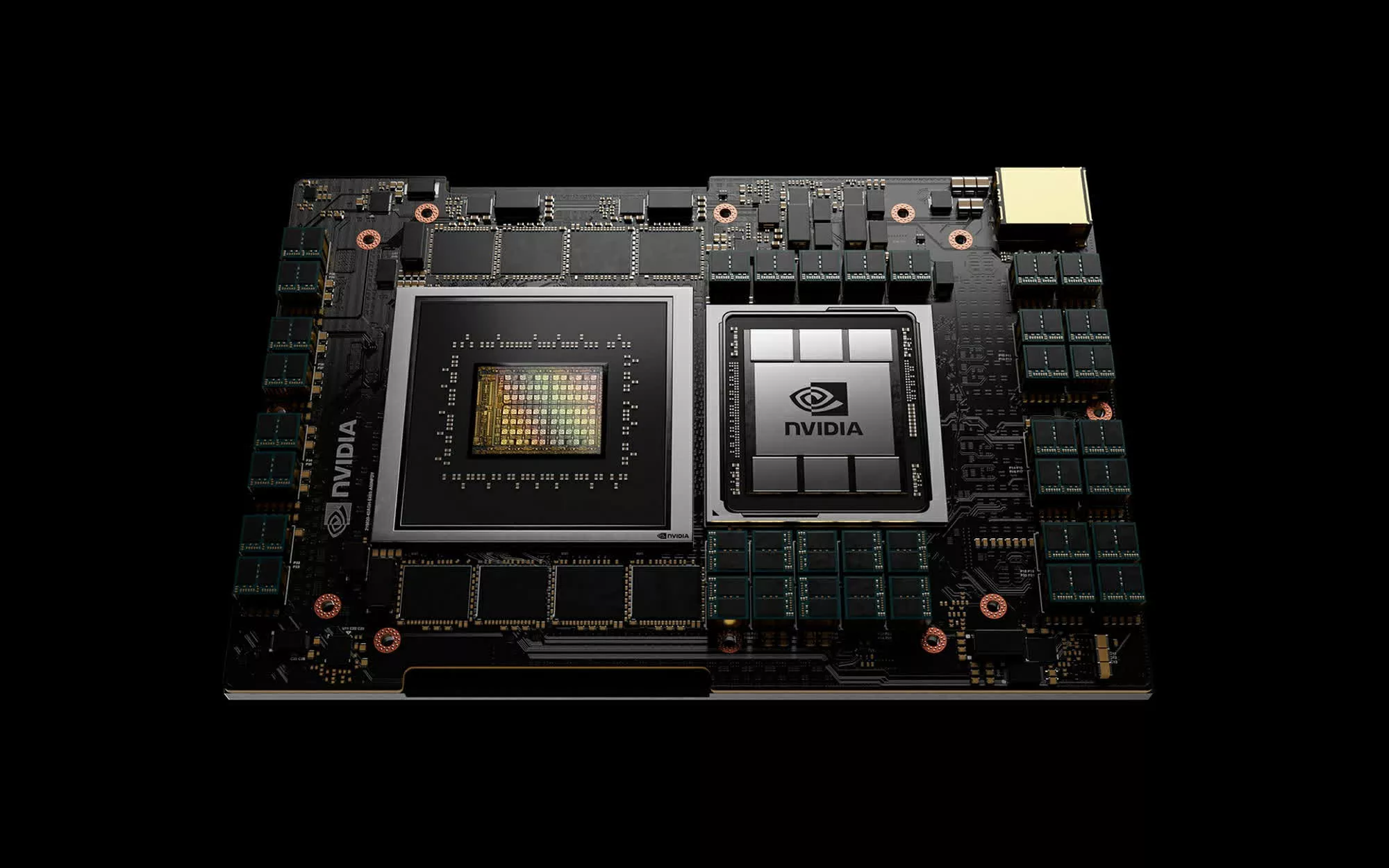

Omdia a inventé le terme « informatique hyper hétérogène » pour décrire une configuration de serveur équipée de coprocesseurs spécifiquement conçus pour optimiser diverses charges de travail, que ce soit pour la formation de modèles d’IA ou d’autres applications spécialisées. Selon Omdia, le modèle DGX de Nvidia, doté de huit GPU H100 ou A100, est devenu le serveur IA le plus populaire à ce jour et est particulièrement efficace pour entraîner des modèles de chatbot.

En plus des offres de Nvidia, Omdia présente les modèles Inferentia 2 d’Amazon comme accélérateurs d’IA populaires. Ces serveurs sont équipés de coprocesseurs sur mesure conçus pour accélérer les charges de travail d’inférence d’IA. Parmi les autres coprocesseurs contribuant à la tendance informatique hyper-hétérogène figurent les unités de codage vidéo (VCU) de Google pour le transcodage vidéo et les serveurs de traitement vidéo de Meta, qui exploitent les processeurs vidéo évolutifs de l’entreprise.

Dans ce nouveau scénario informatique hyper-hétérogène, les fabricants augmentent le nombre de composants en silicium coûteux installés dans leurs modèles de serveurs. Selon les prévisions d’Omdia, les processeurs et coprocesseurs spécialisés représenteront 30 % des dépenses des centres de données d’ici 2027, contre moins de 20 % au cours de la décennie précédente.

Actuellement, le traitement multimédia et l’IA sont à l’honneur dans la plupart des serveurs hyper-hétérogènes. Cependant, Omdia prévoit que d’autres charges de travail auxiliaires, telles que les bases de données et les serveurs Web, disposeront à l’avenir de leurs propres coprocesseurs. Les disques SSD dotés de composants de stockage informatique peuvent être considérés comme une première forme d’accélération matérielle pour les charges de travail d’E/S.

D’après les données d’Omdia, Microsoft et Meta sont actuellement en tête des hyperscalers dans le déploiement de GPU de serveur pour l’accélération de l’IA. Les deux sociétés devraient recevoir 150 000 GPU Nvidia H100 d’ici fin 2023, soit une quantité trois fois supérieure à celle déployée par Google, Amazon ou Oracle.

La demande de serveurs d’accélération de l’IA de la part des sociétés cloud est si élevée que les fabricants d’équipement d’origine comme Dell, Lenovo et HPE sont confrontés à des retards de 36 à 52 semaines pour obtenir suffisamment de GPU H100 de Nvidia pour honorer les commandes de leurs clients. Omdia note que les centres de données puissants équipés de coprocesseurs de nouvelle génération entraînent également une demande accrue d’infrastructures d’alimentation et de refroidissement.